(报告出品方/作者:华西证券,刘泽晶)

核心观点:ChatGPT开启大模型“军备赛”,存储作为计算机重要组成部分明显受益: ChatGPT开启算力军备赛,大模型参数呈现指数规模,引爆海量 算力需求,模型计算量增长速度远超人工智能硬件算力增长速度,同时也对数据传输速度提出了更高的要求。XPU、内存、硬盘组成完整的 冯诺依曼体系,以一台通用服务器为例,芯片组 存储的成本约占70%以上,芯片组、内部存储和外部存储是组成核心部件;存储是计算机的 重要组成结构, “内存”实为硬盘与CPU之间的中间人,存储可按照介质分类为ROM和RAM两部分。

存算一体,后摩尔时代的必然发展: 过去二十年中,算力发展速度远超存储,“存储墙”成为加速学习时代下的一代挑战,原因是在后摩尔 时代,存储带宽制约了计算系统的有效带宽,芯片算力增长步履维艰。因此存算一体有望打破冯诺依曼架构,是后摩时代下的必然选择,存 算一体即数据存储与计算融合在同一个芯片的同一片区之中,极其适用于大数据量大规模并行的应用场景。存算一体优势显著,被誉为AI芯 片的“全能战士”,具有高能耗、低成本、高算力等优势;存算一体按照计算方式分为数字计算和模拟计算,应用场景较为广泛,SRAM、 RRAM有望成为云端存算一体主流介质。

存算一体前景广阔、渐入佳境: 存算一体需求旺盛,有望推动下一阶段的人工智能发展,原因是我们认为现在存算一体主要AI的算力需求、 并行计算、神经网络计算等;大模型兴起,存算一体适用于从云至端各类计算,端测方面,人工智能更在意及时响应,即“输入”即“输 出”,目前存算一体已经可以完成高精度计算;云端方面,随着大模型的横空出世,参数方面已经达到上亿级别,存算一体有望成为新一代 算力因素;存算一体适用于人工智能各个场景,如穿戴设备、移动终端、智能驾驶、数据中心等。我们认为存算一体为下一代技术趋势并有 望广泛应用于人工智能神经网络相关应用、感存算一体,多模态的人工智能计算、类脑计算等场景。

01、存算一体,开启算力新篇章1.1、ChatGPT开启大模型“军备赛”,算力呈现明显缺口

ChatGPT开启算力军备赛: 我们已经在《ChatGPT: 百度文心一言畅想》中证明数据、平台、算力是打造大模型生态的必备基础,且算力 是训练大模型的底层动力源泉,一个优秀的算力底座在大模型(AI算法)的训练和推理具备效率优势;同时,我们在《ChatGPT打响AI算 力“军备战”》中证明算力是AI技术角逐“入场券”,其中AI服务器、AI芯片等为核心产品;此外,我们还在《ChatGPT , 英伟达DGX 引爆 AI “核聚变”》中证明以英伟达为代表的科技公司正在快速补足全球AI算力需求,为大模型增添必备“燃料”。

大模型参数呈现指数规模,引爆海量算力需求: 根据财联社和OpenAI数据,ChatGPT浪潮下算力缺口巨大,根据OpenAI数据,模型计算 量增长速度远超人工智能硬件算力增长速度,存在万倍差距。运算规模的增长,带动了对AI训练芯片单点算力提升的需求,并对数据传 输速度提出了更高的要求。根据智东西数据,过去五年,大模型发展呈现指数级别,部分大模型已达万亿级别,因此对算力需求也随之 攀升。

1.2、深度拆解服务器核心硬件组成部分

服务器的组成: 我们以一台通用服务器为例,服务器主要由主 板、内存、芯片组、磁盘、网卡、显卡、电源、主机箱等硬件 设备组成;其中芯片组、内部存储和外部存储是组成核心部件。 GPU服务器优势显著: GPU服务器超强的计算功能可应用于海 量数据处理方面的运算,如搜索、大数据推荐、智能输入法等, 相较于通用服务器,在数据量和计算量方面具有成倍的效率优 势。此外,GPU可作为深度学习的训练平台,优势在于1、 GPU 服务器可直接加速计算服务,亦可直接与外界连接通信; 2、GPU服务器和云服务器搭配使用,云服务器为主,GPU服 务器负责提供计算平台;3、对象存储 COS 可以为 GPU 服务 器提供大数据量的云存储服务。

AI服务器芯片组价值成本凸显: 以一台通用服务器为例,主板 或芯片组占比最高,大约占成本50%以上,内存(内部存储 外部 存储)占比约为20%。此外,根据Wind及芯语的数据,AI服务器 相较于高性能服务器、基础服务器在芯片组(CPU GPU)的价格往 往更高,AI服务器(训练)芯片组的成本占比高达83%、AI服务器 (推理)芯片组占比为50%,远远高于通用服务器芯片组的占比。

1.3、存储,计算机的重要组成结构

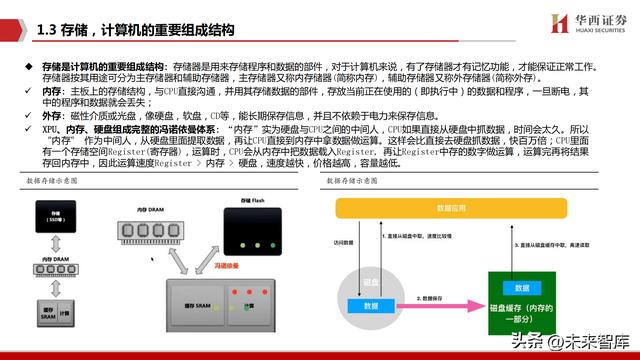

存储是计算机的重要组成结构: 存储器是用来存储程序和数据的部件,对于计算机来说,有了存储器才有记忆功能,才能保证正常工作。 存储器按其用途可分为主存储器和辅助存储器,主存储器又称内存储器(简称内存),辅助存储器又称外存储器(简称外存)。 内存: 主板上的存储结构,与CPU直接沟通,并用其存储数据的部件,存放当前正在使用的(即执行中)的数据和程序,一旦断电,其 中的程序和数据就会丢失; 外存: 磁性介质或光盘,像硬盘,软盘,CD等,能长期保存信息,并且不依赖于电力来保存信息。

XPU、内存、硬盘组成完整的冯诺依曼体系: “内存”实为硬盘与CPU之间的中间人,CPU如果直接从硬盘中抓数据,时间会太久。所以 “内存” 作为中间人,从硬盘里面提取数据,再让CPU直接到内存中拿数据做运算。这样会比直接去硬盘抓数据,快百万倍;CPU里面 有一个存储空间Register(寄存器),运算时,CPU会从内存中把数据载入Register, 再让Register中存的数字做运算,运算完再将结果 存回内存中,因此运算速度Register > 内存 > 硬盘,速度越快,价格越高,容量越低。

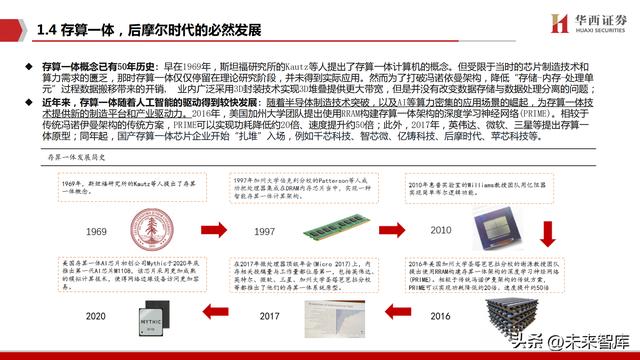

1.4、存算一体,后摩尔时代的必然发展

算力发展速度远超存储,存储带宽限制计算系统的速度: 在过去二十年,处理器性能以每年大约55%的速度提升,内存性能的提升速度 每年只有10%左右。因此,目前的存储速度严重滞后于处理器的计算速度。能耗方面,从处理单元外的存储器提取所需的时间往往是运 算时间的成百上千倍,因此能效非常低;“存储墙”成为加速学习时代下的一代挑战,原因是数据在计算单元和存储单元的频繁移动。

存储墙、带宽墙和功耗墙成为首要限制关键: 在传统计算机架构中,存储与计算分离,存储单元服务于计算单元,因此会考虑两者优先 级;如今由于海量数据和AI加速时代来临,不得不考虑以最佳的配合方式为数据采集、传输、处理服务,然而存储墙、带宽墙和功耗墙 成为首要挑战,虽然多核并行加速技术也能提升算力,但在后摩尔时代,存储带宽制约了计算系统的有效带宽,芯片算力增长步履维艰。

1.5、存算一体:AI芯片的“全能战士”

存算一体优势显著,被誉为AI芯片的“全能战士”其优势如下: 1、成百上千倍的提高计算效率,降低成本:存算一体的优势是打破存储墙,消除不必要的数据搬移延迟和功耗,使用存储单元提升算力; 2、特定领域提供更高算力与能效:存算一体架构消除了计算与存储的界限,直接在存储器内完成计算,因此属于非冯诺伊曼架构,在特 定领域可以提供更大算力(1000TOPS以上)和更高能效(超过10-100TOPS/W),明显超越现有ASIC算力芯片; 3、存算一体代表了未来AI计算芯片的主流架构: 除AI计算外,存算技术也可用于感存算一体芯片和类脑芯片,可减少不必要的数据搬 运与使用存储单元参与逻辑计算提升算力,原因在于等效于在面积不变的情况下规模化增加计算核心数。

1.6、存算一体存储介质百花齐放

存算一体应用场景极其广阔: 端侧小算力场景,算力范围约从16TOPS至100TOPS,例如智 能可穿戴设备、智能安防、移动终端、ARVR等。大算力场景,算力序曲在1000TOPS以上, 例如云计算数据中心、自动驾驶、GPT-4等大模型等。我们认为云和边缘大算力场景,是 存算一体芯片的优势领域,存算一体更具备核心影响力和竞争力;

SRAM、RRAM有望成为云端存算一体主流介质: 目前可用于存算一体的成熟存储器有NOR FLASH、SRAM、DRAM、RRAM、MRAM等;Nor Flash属于非易失性存储介质,在工艺制成上有 明显瓶颈;DRAM成本较低,容量大,但是速度慢;SRAM在速度方面和能效比方面具有优势, 特别是在存内逻辑技术发展起来之后具有明显的高能效和高精度特点;此外,PRAM有望成 为下一代主流研究方向,虽然目前来看材料依旧不稳定,但是具有高速、结构简单的优点, 有希望成为未来发展最快的新型存储器。

02、存算一体,打开海量应用空间2.1、存算一体前景广阔、渐入佳境

存算一体需求旺盛,有望推动下一阶段的人工智能发展: 我们认为现在存算一体主要AI的算力需求、并行计算、神经网络计算等,因此 存算一体需求旺盛;以数据中心为例,百亿亿次(E级)的超级计算机成为各国比拼算力的关键点,为此美国能源部启动了“百亿亿次 计算项目”,我国则联合国防科大、中科曙光等机构推出首台E级超算,而E级超算面临的主要问题为功耗过高、现有技术超算功率高达 千兆瓦,需要一个专门的核电站来给它供电,而其中50%以上的功耗都来源于数据的“搬运”,本质原因是计算与存储分离所致。

大模型兴起,存算一体适用于从云至端各类计算: ChatGPT等“大模型”兴起,本质即为神经网络、深度学习等计算,因此,我们认为 对算力需求旺盛;端测方面,人工智能更在意及时响应,即“输入”即“输出”,同时,随着存算一体发展,存内计算和存内逻辑,已 经可以完成高精度计算;云端方面,随着大模型的横空出世,参数方面已经达到上亿级别,因此对算力的能耗方面考核更加严格,随着 SRAM和PRAM等技术进一步成熟,存算一体有望成为新一代算力因素,从而推动人工智能产业的发展。

2.2、存算一体为人工智能发展的必然选择

我们认为存算一体为下一代技术趋势,原因及创新应用科技场景如下:人工智能神经网络相关应用:存算一体具有能耗优势,其使用成本能大幅降低,可将带AI计算的中大量乘加计算的权重部分存在存储单元中从而在读取的同时进行数据输入和计算处理,从而完成卷积运算。因此存内计算和存内逻辑非常适合人工智能的深度神经网络应用和基于AI的大数据技术;

感存算一体,多模态的人工智能计算: 集传感、储存和运算为一 体构建感存算一体架构,我们认为其为多模态时代下的应用场景, 通过传感器AI存算一体芯片,来实现零延时和超低功耗的智能视 觉处理能力。我们认为其融入了CV(计算机视觉)、PRA(过程自动 画)、神经网络计算等多种计算方式,存算一体芯片具有时效、能 耗等多重优势; 存算一体是类脑计算的关键技术基石: 类脑计算又称神经形态计 算,是借鉴生物神经系统信息处理模式和结构的计算理论、体系 结构、芯片设计等算法总称;类脑计算属于大算力高能耗反冲, 存算一体极其适合大算力领域,因此天然适合应用在类脑计算领 域,是类脑计算的关键技术基石。

报告节选:

(本文仅供参考,不代表我们的任何投资建议。如需使用相关信息,请参阅报告原文。)

精选报告来源:【未来智库】「链接」

相关文章

猜你喜欢