(图片来源:Shutterstock)

国内人工智能(AI)大模型行业到底有多火?你看看下面消息就知道了。

仅4月18日一天,就有6个关于大模型的重要消息公布:

钉钉宣布正式接入阿里巴巴“通义千问”大模型;字节跳动旗下火山引擎发布自研DPU(数据处理单元)芯片,以及发布大模型训练云平台等;金山办公宣布将推出 WPS AI,类似于基于ChatGPT技术的微软Copilot产品,金山办公CEO章庆元透露这一技术由国内企业MiniMax提供;APUS在北京推出1000亿个参数、自研多模态的天燕大模型AiLMe,以及基于其技术的 7 款 AI 消费端应用App;在上海车展媒体日上,斑马智行宣布接入“通义千问”大模型,智己汽车成为首个上车品牌;百度“文心一言”大模型全面应用内部智能工作平台“如流”。另外在18日举行的2023全球元宇宙大会上,GPT产业联盟正式成立。据悉,该联盟由中国移动通信联合会、中国电信、中国移动、中国联通、中国广电等单位共同发起。

在ChatGPT风靡之下,国内互联网科技大厂纷纷下场。阿里、华为、腾讯、知乎、商汤、百度、京东、360、昆仑万维等企业加入到 AI 大模型竞争中,一把手带队,中国 AI 行业的“百模大战”全面打响。

与此同时,海外GPT热潮仍在持续。马斯克确认自建 AI 聊天机器人项目 TruthGPT,将与OpenAI展开竞争;拥有ChatGPT技术能力的微软,被传出正在研发助力大模型的 AI 芯片,内部代号“雅典娜”(Athena)。

行业普遍认为,如今大家扎堆创业做大模型是一件好事。

APUS创始人、CEO李涛对钛媒体App表示,互联网沉寂很久,无论加密数字货币还是Web3,都不是一个颠覆性、革命性的东西。IT 产业的创新在过去两三年几乎没有任何东西,如今扎堆创业做大模型,一方面是疫后经济能量的释放,同时也是整个IT产业的技术创新机会,重燃了所有人心中的火焰。

国产GPT模型“大跃进”,避免不了“翻车”毫无疑问,ChatGPT已经在全球爆火。自去年11月发布至今,ChatGPT访问量已飙升至8.89亿次,也是历史上最快达到1亿月活的应用,而且整个热潮已蔓延至科技大厂、学术界、产业界当中。

最近国内也刮起了ChatGPT风潮。阿里通义千问、百度文心一言、商汤日日新SenseNova体系、华为云盘古、知乎“知海图 AI”、360GPT、昆仑万维“天工”和京东言犀等大模型产品陆续公布。小米CEO雷军4月14日发微博表示,小米全力以赴、坚决拥抱大模型和生成式人工智能(AIGC),并将推出相关技术和产品。

“这两个月GPT大模型风靡全球,远超过去十年中国 AI 技术与产业的发展热度,也使得过去二十年互联网科技发展被取代。”一位行业人士告诉钛媒体App,这是继2021年“AI 四小龙”(商汤、旷视、云从、依图)集体被美国制裁之后,国内 AI 行业的新一轮热潮。

正如开头所讲,过去一天内,就6个关于大模型的重要消息。

首先是18日上午的北京钉峰会上,钉钉宣布正式接入阿里巴巴“通义千问”大模型,输入斜杠“/”即可唤起智能服务,因此钉钉产品将全面启动智能化战略,升级成为智能协同办公平台、智能应用开发平台。此外,钉钉斜杠还能根据需求撰写文案、设计海报等。

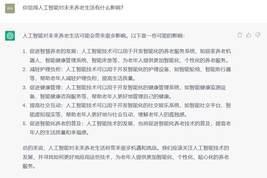

不过在现场演示当中,钉钉似乎出现了“翻车”。在文生图演示中,钉钉出现和文心一言类似问题,即输入“赴汤蹈火”表情,却出现了一锅汤上面有一只着火的类似汤圆造型的动漫人物,随后引发广泛热议。

左面两个是钉钉现场演示的“赴汤蹈火”表情包,右侧是钛媒体App在文心一言中输出的“赴汤蹈火”图片

一位参加钉钉发布会的行业人士告诉钛媒体App,当时钉钉总裁叶军并不满意输出的“赴汤蹈火”表情图片,反复更新了三次。

现场视频显示,叶军表示,输出生成的表情包功能同样由阿里巴巴“通义千问”大模型所支撑,此前效果更差,而如今效果好了一点点,“目前通义大模型还在训练中,文生图效果仍有进步空间。”

随着国产GPT模型“大跃进”,演示“翻车”情况似乎避免不了。此前钛媒体App内测时发现,当输入“画一幅‘驴肉火烧”时,AI 会画出一只驴和火;输入“画一幅鱼香肉丝”时,就会出现一只丝装的红色活鱼。百度对此声明称,文心一言完全是百度自研的大语言模型,训练过程中使用了互联网公开数据。

一位大厂的技术负责人王洋(化名)4月18日对钛媒体App表示,上述“翻车”问题意味着产品周期较短,因为 AI 推理应用过程中往往需要更多的数据,但全球互联网产业来看,英文高质量的预料多一些,“我认为(文心一言)确实推出比较匆忙,但我觉得这不是本质性问题,可能需要积累很长时间的中文语料数据集。”

除钉钉之外,4月18日上午,字节跳动旗下火山引擎发布大模型训练云平台,包括自研DPU、机器学习平台等系列云和 AI 基础设施产品,支持万卡级大模型训练、微秒级延迟网络。与大模型不同的是,火山引擎主要为多家大模型公司提供算力等技术服务。据财新,字节跳动两个团队并行做大模型,一个做语言,另一个做音视频。

去年3月,字节跳动曾推出开源大模型训练框架veGiantModel ,性能最高提升6.9倍。

钛媒体App了解到,由于高端GPU存在出口限制,字节跳动此前囤积了大量英伟达A100、V100 GPU(图形处理器)显卡芯片,拥有目前国内性能最高的 AI 算力能力之一,这意味着字节或能直接解决当下 AI 训练与推理所需的算力挑战,而可预见的算力需求激增已经让火山引擎推算力云方案。

而在18日下午2点,美团融新科技中心办公室楼上,一家刚刚战略转型 AI 技术的麒麟合盛网络技术股份有限公司(APUS),正式推出1000亿个参数、自研多模态的天燕大模型AiLMe,以及基于该模型的智能问答大师、简笔成画等 7 款 AI 消费端产品。公司创始人、CEO李涛向钛媒体App透露,为了做好大模型,APUS前期累计花掉接近1000万美金。(详见钛媒体App前文:《APUS发布1000亿天燕大模型AiLMe,CEO称日活用户已超百万》)

此外,4月18日,金山办公正式发布具备大语言模型能力的生成式人工智能应用“WPS AI”,搭载在其新一代在线内容协作编辑工具“轻文档”(airPage)上,据金山办公CEO章庆元透露,WPS AI所用大模型非OpenAI,由国内合作伙伴MiniMax提供;同时在上海车展期间,阿里集团旗下的斑马智行宣布接入“通义千问”大模型,智己汽车成为首个上车品牌;百度则宣布“文心一言”大模型全面应用内部沟通产品“如流”当中。

如今,为了争夺“中国版OpenAI”席位,科技巨头、商业大咖纷纷下场加入ChatGPT竞争当中,“重复造轮子”情况已然发生,“你有我也要有”、“人人都做大模型”时代正在到来。

李涛对钛媒体App表示,今天,整个中国的 AI 相当于全球来说是比较落后,无论是比OpenAI,还是比谷歌,还是比Meta,中国 AI 落后的绝对不是两个月、三个月的问题,起码落后两年以上。但我们要相信,未来很长时间里面,AI 迭代,算法快速改进和优化可能会帮助中国快速大踏步追赶,甚至有机会跟世界拉平。“我不愿意用弯道超车,事实上没有弯道超车的可能性,所有的机会都是要付出足够大的成本,付出时间、精力、物力才能做到。”

对于是否存在大模型“重复造轮子”,王洋对钛媒体App表示,从商业角度来说,重复做大模型的情况很正常。科技大厂一定会在大模型领域展开竞争、合作,需要市场的商业化。这是一个非常严酷的市场检验过程,否则企业就永远是“温室里的花朵”。

搜狗创始人、百川智能创始人王小川告诉钛媒体App,他认为最终科技大厂会一人推出一个模型,本轮参与的创业公司里面可能最终只有不到5个大模型会拿到“通行船票”。

ChatGPT算力不足,传微软正自研AI芯片“Athena”与国内“百模大战”一样,国外ChatGPT热潮似乎也未结束。

继特斯拉CEO马斯克(Elon Musk)宣布做ChatGPT竞品TruthGPT之后,据The Information 4月18日报道,创造ChatGPT的美国OpenAI公司,其背后的大股东微软正在开发自研的AI芯片,内部代号「雅典娜」(Athena),300人共同研发。

据两名知情人士透露,微软正在开发代号为“Athena”的AI芯片,以便应用于ChatGPT背后的生成式AI技术,包括训练大型语言模型(LLM)和AI推理(inference)。据悉,首款Athena芯片将采用台积电5nm工艺。

消息称,微软早在2019年就已开始著手研发这款芯片,由微软和OpenAI员工共同进行测试,微软目前使用的AI芯片是对外采购,而非自家产品。微软希望Athena AI芯片的性能能够超越供应商的芯片,以进一步降低开发AI所需耗费的资金成本和时间。目前,微软等厂商已经在其60多个数据中心部署了数十万张GPU芯片,用于 AI 模型的日常推理。

事实上,随着生成式 AI 大爆发,包括亚马逊和谷歌等科技巨头都已推出自研AI芯片。去年11月,亚马逊宣布推出高性能服务器芯片Graviton 3E,挑战英特尔和英伟达。

不过,一方面是算力需求增长较快,包括亚马逊、微软、Google 和甲骨文等主要云计算供应商都在限制客户对云服务器的使用,租用硬件的等待时间长达数月,核心问题仍是GPU(图形处理器)等算力芯片供不应求;另一方面,目前在机器学习、加速计算等领域,英伟达(NVIDIA)GPU领域市占率高达95%以上,至今没有对手可以匹敌。

早前美国媒体报道称,马斯克囤积购买了约1万个GPU芯片,用来处理 AI 大模型项目TruthGPT,而且将推特的两个数据中心用起来,使用推特的内容作为数据,来训练其语言模型,也可以利用特斯拉的计算资源。

根据英伟达官方信息,训练一次1750亿参数的GPT-3需要34天、使用1024张A100 GPU芯片,同时,OpenAI可能至少需要3.24万张A100用于日常推理,显著高于此前训练底层模型时的用量,以此推算,ChatGPT硬件成本达8亿美元以上。

研究公司SemiAnalysis首席分析师迪伦·帕特尔 (Dylan Patel)表示,经计算,ChatGPT运营成本每天约为70万美元,大部分成本是基于所需的昂贵服务器。“与英伟达的产品相比,微软Athena如果具有竞争力,可以将每个芯片的成本降低三分之一。因为基于GPT技术的微软产品,未来如果使用现成的硬件大规模部署,每年将花费数百亿美元。”

Forrester Research分析师Tracy Woo 表示,AI 技术的繁荣给云厂商带来了很大压力,要求他们开发自己的芯片。“你可以从英伟达购买,但谷歌、亚马逊这样的巨头,他们有足够的资金来构建和设计自己的芯片。”

另据报道,网络芯片巨头博通(Broadcom)4月18日发布最新ericho3-AI芯片,用于将超级计算、AI 大模型等领域,可将多达3.2万个GPU芯片连接在一起,将与英伟达等公司竞争。

随着GPT-4发布,市场普遍认为需百倍的芯片及其算力支持,英伟达(NASDAQ: NVDA)股价也随即飙升,年初至今已大涨86%以上。(本文首发钛媒体App,作者|林志佳)

相关文章

猜你喜欢