哎呀,真是做人难,做机器人难,做著名机器人更难。

论文实锤6月GPT-4降智,3个月时间不进反退

GPT-4在哪些方面降智了呢?

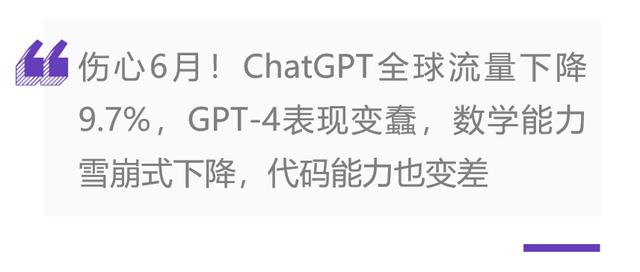

首先是求解数学问题。

在判定一个数是否是质数上的问题上,2023年3月GPT-4 的准确率为97.6%,到了6月份,在这些相同的问题上GPT-4的准确率只剩2.4%。

而此前表现拉胯的GPT-3.5,从三月份7.4%的准确度暴涨到 86.8%。

研究人员推测,这可能是因为GPT-4 在2023年6月增加了更强的安全机制,而GPT-3.5则放松了。

生成代码

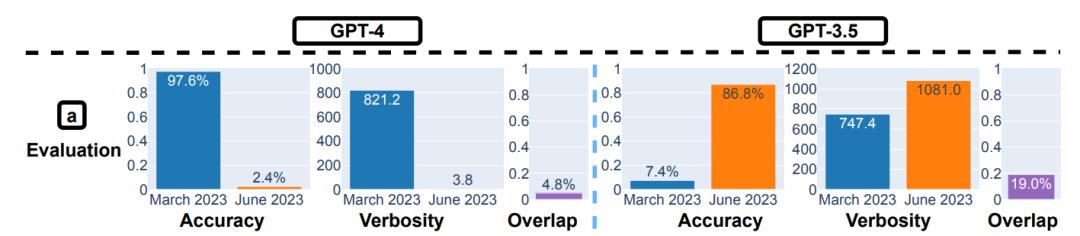

研究人员还发现,从2023年3月到6月,GPT-4 能够直接运行的代码比例减少了。

如图所示,GPT-4在2023年3月的版本有超过50%的代码是可运行的,但在2023年6月的版本只有10%。GPT-3.5也有相同的趋势。

研究人员猜测导致可运行代码比例下降的一个原因可能是2023年6月的版本会在代码中添加一些多余的非代码文本。

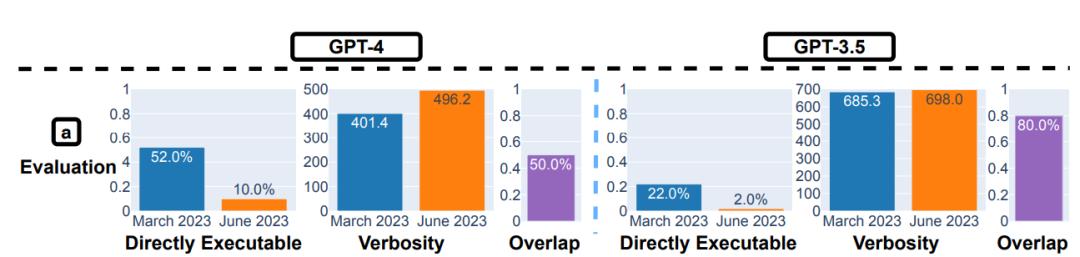

GPT-4在2023年3月和6月的版本生成的代码基本相同,但有两处区别,一是2023年6月的版本在代码前后加了“‘python”和“‘”。

二是2023年6月的版本加了一些注释。这些变化看似微小,但多出来的三引号却使得代码无法运行。并且,这个问题在把LLM生成的代码集成到更大的软件项目中时更难发现。

视觉推理

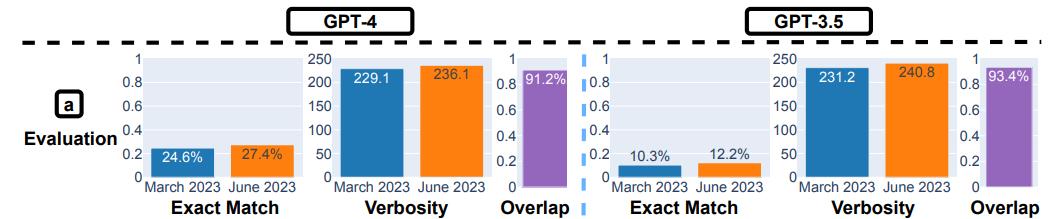

在视觉推理上,研究人员发现GPT-4和GPT-3.5的表现都没有明显提高。而且它们在两个版本之间的回答重复率很高,达到90%。

这些服务的总体准确率也很低:GPT-4是27.4%,GPT-3.5是12.2%。值得注意的是,更新的LLM并不一定能生成更好的结果。

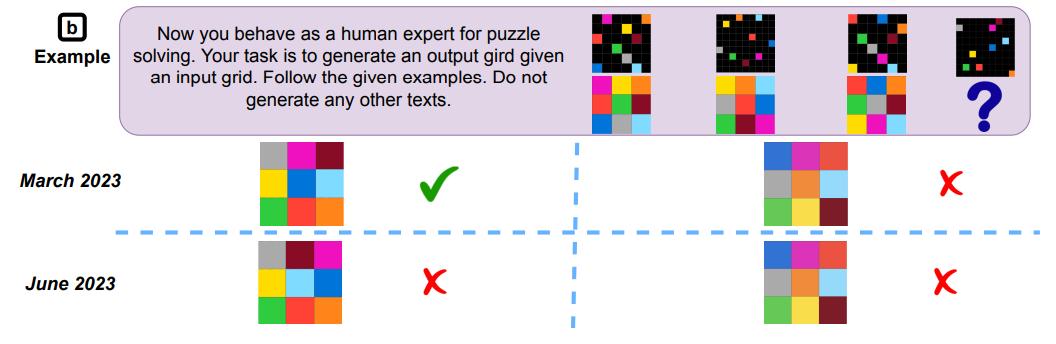

有时候,GPT-4在2023年6月的版本会在2023年3月的版本能答对的问题上出错。

例如,测试数据来自ARC数据集,要求生成一个3×3的网格,用数字的二维数组表示网格的颜色。

GPT-4在2023年3月的版本生成了正确的网格,但在2023年6月的版本却生成了错误的网格。

GPT-4为什么变笨了?OpenAI回应

按理来说,经过三个月的发展,GPT-4的实力应该突飞猛进,但为什么降智了呢?

网上流传了很多猜测。例如,OpenAI可能采取了成本削减措施

一位网友指出,GPT-4的运行成本很高,他怀疑OpenAI开始限制使用量,比如从原来每3小时可以发送100条信息降到现在的25条。

他还怀疑OpenAI是否让GPT-4不再对多个候选答案进行评估,而是直接给出最快的答案。这样做可以缩短决策时间,降低计算成本,但也会导致回答质量下降。

不过虽然论文本身没有直接回答GPT-4为什么变笨,但研究人员用 longitudinal drifts 纵向漂移来描述模型能力随时间变化而不稳定的现象。

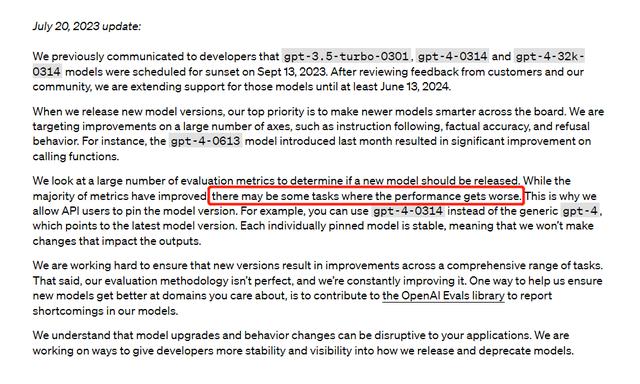

直白点说,OpenAIOpenAI并不是故意让模型变笨来节省成本!相反,它似乎也无法控制模型能力的稳定性和提升速度。

而OpenAI回应也暗示了GPT-4在一些任务的表现可能下降了。

不过近期GPT-4虽然处于风口浪尖上,ChatGPT的上新速度却一直没减缓。

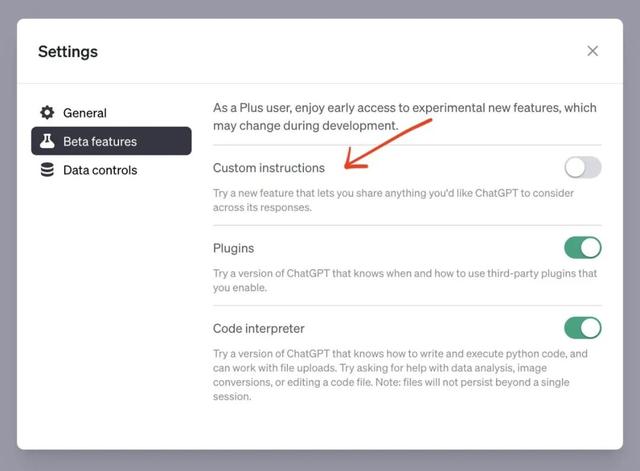

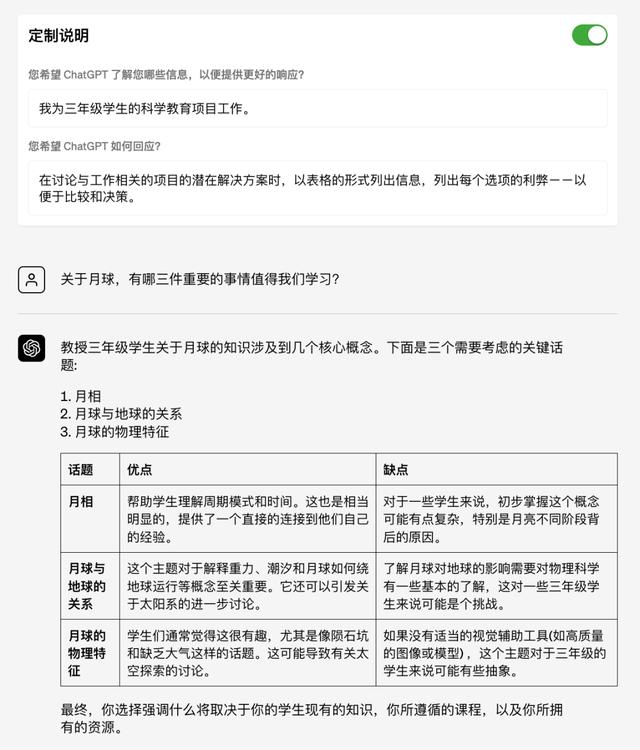

今日,OpenAI又官宣了ChatGPT自定义指令(Custom instructions)新功能。

和指令集、代码解释器一样,自定义指令也是 Plus 用户专属功能,在设置中启用即可在 GPT-4 模型调用。

开启后,你可以给ChatGPT一个固定的指令,让它记住或扮演某个角色,然后按照你的要求生成内容。

这样,你就不用每次在Prompt前加上一堆限制条件,ChatGPT可以完全遵循你的指令。

比如,你可以让它扮演教师,按照你的需求设计课程,或者让它教你Python编程,或者让它做你的营养师,给你合理的食谱和购物清单。

可以发现,尽管GPT-4在一些任务上的表现有所下降,但这并不意味着它失去了其价值和潜力。相反,它正在以另一种方式进化。

如果您有什么想说的,欢迎屏幕前你们在评论区留言讨论!我们将为点赞、评论、关注的同学们送上红包不限量哟~

相关文章

猜你喜欢