作者 | 小戏、Python

关于大模型的商业落地,一个非常容易想到的场景就是智能客服,作为不止是大模型也是 NLP 领域的一个最主要的应用场景,由于人工客服的高昂成本,AI 客服伴随着模型技术的发展也逐步走进我们的生活,在手机里各种主要的 APP 几乎都配备了一个智能客服。

而以 Chat 命名的大规模语言模型(LLMs)似乎天然的适配智能客服的应用场景,大模型驱动的智能客服也是一个非常具有想象力的落地方向。但是,在今年的 ACL 2023 中,来自对话式 AI 科技公司 LivePerson 的研究人员针对大模型“取代”客服工作算了一笔经济账,结果发现,用 GPT-3 等大模型做智能客服的 Backbone 反而有可能要赔钱?

为了获取针对这些“智能客服”回答响应的“有用程度”,论文采用专家打分的方式,对这些模型的每个对话进行了接受、编辑与忽略的评分判断,哪怕对于人工客服,人们也并不总是接受他们的回复,而在智能客服中,基于 GPT-3 的模型表现最佳。

具体而言,AR 零售商使用 GPT-2 BFT BD 单条消息可以节省 4.47 美分,根据 AR 每年的消息数量 1200000 条来计算,使用 GPT-2 模型可以节约 53653 美元,而使用 GPT-3 模型则可能要亏损约 18691 美元。

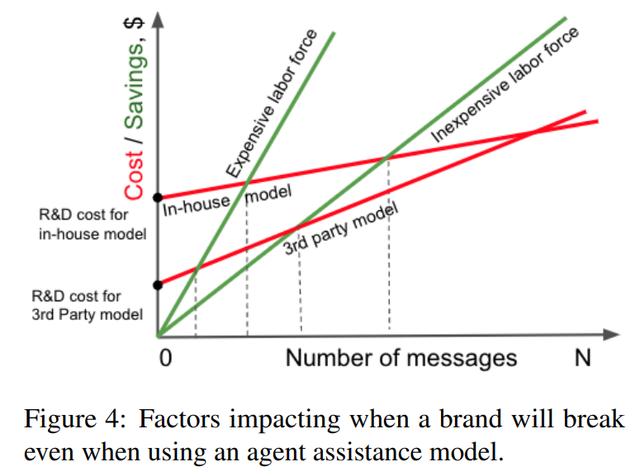

针对计算得到的 ENCS,可以为每个模型计算得到一个盈亏平衡点,如下图所示,当绿色线(劳动力成本节约)与红色线(模型建设投入)相交时达到盈亏平衡,可以得到,对于一个每年消息总量约 500000 条的小企业而言,使用大模型构建智能客服必须快速的降低前期的研发成本,而对于一个每年约有 2000 万条消息的大企业而言,使用大模型构建智能客服才会真正带来成本节约。

总结与讨论

总结与讨论这篇论文针对大模型应用在智能客服领域的商业场景进行了细致深入的研究,同时提出了一种评估大模型响应到底带来了多少“成本节约”问题的分析框架 ENCS,给出了一个有点反直觉但是又十分合理的结论——在当下大模型的应用成本仍然较高,只有大企业的大体量带来的规模效应才有可能有动力去完成大模型的实际部署,对于小企业而言大模型的应用成本仍然过高。不过这些分析也主要试图提供一些管理、决策之上的洞见,在更细致的成本测算之上还有许多工作需要去做,当然,最后,这些洞见不仅呼唤着大模型的技术进步为我们带来成本的降低,也呼唤着一些第三方平台企业的出现解决一些小企业用不起大模型的现实问题,且让我们期待一下大模型未来的进步吧!

论文题目:The economic trade-offs of large language models: A case study

相关文章

猜你喜欢