机器之心报道

机器之心编辑部

这就是 GPT 的「抽象」,和人类的抽象不太一样。

虽然 ChatGPT 似乎让人类正在接近重新创造智慧,但迄今为止,我们从来就没有完全理解智能是什么,不论自然的还是人工的。

认识智慧的原理显然很有必要,如何理解大语言模型的智力?OpenAI 给出的解决方案是:问问 GPT-4 是怎么说的。

5 月 9 日,OpenAI 发布了最新研究,其使用 GPT-4 自动进行大语言模型中神经元行为的解释,获得了很多有趣的结果。

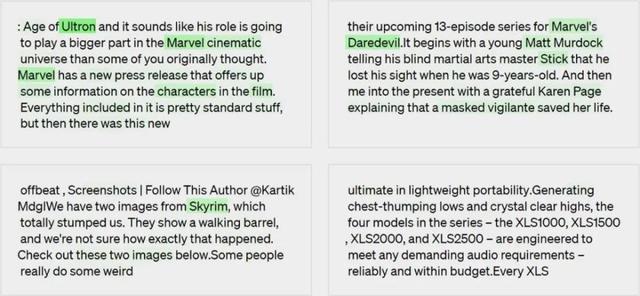

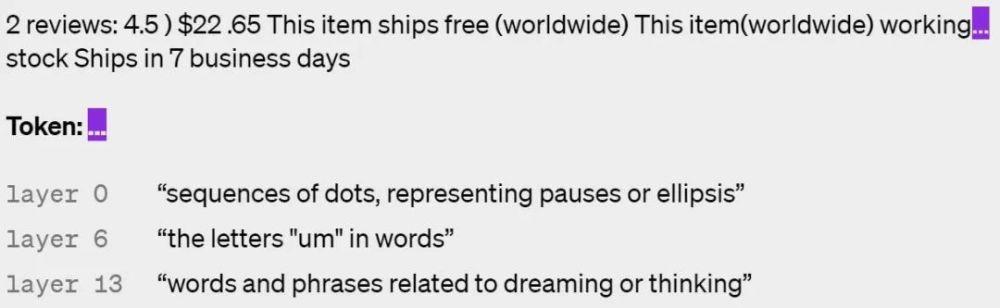

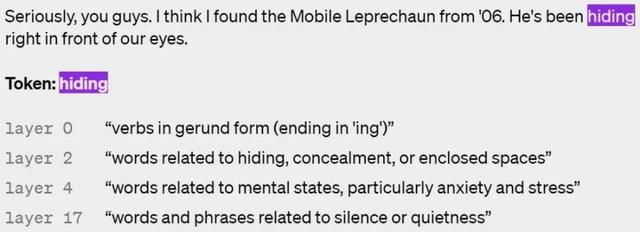

给定一个 GPT-2 神经元,通过向 GPT-4 展示相关文本序列和激活来生成对其行为的解释。

模型生成的解释:对电影、角色和娱乐的引用。

步骤二:使用 GPT-4 进行模拟

再次使用 GPT-4,模拟被解释的神经元会做什么。

看起来,GPT 理解的概念和人类不太一样?

OpenAI 未来工作

目前,该方法还存在一些局限性,OpenAI 希望在未来的工作中可以解决这些问题:

该方法专注于简短的自然语言解释,但神经元可能具有非常复杂的行为,因而用简洁地语言无法描述;

OpenAI 希望最终自动找到并解释整个神经回路实现复杂的行为,神经元和注意力头一起工作。目前的方法只是将神经元的行为解释为原始文本输入的函数,而没有说明其下游影响。例如,一个在周期(period)上激活的神经元可以指示下一个单词应该以大写字母开头,或者增加句子计数器;

OpenAI 解释了神经元的这种行为,却没有试图解释产生这种行为的机制。这意味着即使是得高分的解释在非分布(out-of-distribution)文本上也可能表现很差,因为它们只是描述了一种相关性;

整个过程算力消耗极大。

最终,OpenAI 希望使用模型来形成、测试和迭代完全一般的假设,就像可解释性研究人员所做的那样。此外,OpenAI 还希望将其最大的模型解释为一种在部署前后检测对齐和安全问题的方法。然而,在这之前,还有很长的路要走。

参考内容:

https://openai.com/research/language-models-can-explain-neurons-in-language-models

https://news.ycombinator.com/item?id=35877402

https://techcrunch.com/2023/05/09/openais-new-tool-attempts-to-explain-language-models-behaviors/

相关文章

猜你喜欢