除了算力,超大AI模型对电力的需求同样让人吃惊,GPT-3被训练一次就要消耗电量19万度,按照美国碳排放标准计算,大约产生了85000kg二氧化碳当量。

可如今,对更大AI模型的疯狂追求却成了趋势。尤其是在AlphaGo以5比4的成绩击败李世石之后,各家科技巨头像着魔一般,疯狂挑战超大AI模型。在OpenAI推出GPT-3之后,微软和英伟达也不甘心被落下,一年后立马公布了拥有5300亿参数的MT-NLG大模型。

所以,研究人员现在不得不面对一个现实困境,智能算力越来越不够用。在半导体产业,摩尔定律广为人知,芯片中的晶体管每隔18个月左右,基本会翻一番,性能同时会提升一个档次。而从2012年以来,人工智能产业也呈现了类似规律,复杂的AI训练任务所需的算力,每3.43个月就会翻倍。OpenAI在整理2012到2018年算力数据后,更是发现了一个惊人的事实,六年时间内,AI算力需求竟然增长了30万倍,这比摩尔定律更震撼。

中国工程院院士郑纬民曾指出,下一代AI的发展亟需建设大规模AI算力基础设施,GPT-3取得了很好的进步,但是离强人工智能还有差距,下一代人工智能模型可能超过万亿参数。

当AI大模型成为推动AI能力提升的重要工具和手段时,它的非线性甚至是几何式增长的参数数量,将导致AI大模型、巨量模型的计算规模越来越大,需要的硬件资源越来越多,对算力需求及其巨大。若是步入强人工智能时代,所需算力更是将呈现几何倍增长。

02

更强的算力中心急需降温

在算力需求嗷嗷待哺的同时,如何给数据中心节电省钱,也成了工程师们必须面对的难题,光是2021年,全国近2.6%的电力都用在了数据中心运维上,且年电力消耗增速超过60%。所以,各地数据中心面临节能减排的重任,而接二连三的政府文件,也恰好证明了这一点。

2017年,国务院印发的《“十三五”节能减排综合工作方案》明确要求,新建的大型云计算数据中心能源利用效率值(PUE)要优于1.5。2021年,政府发布的《新型基础设施绿色高质量发展实施方案》又再次强调,到2025年,国家枢纽节点的PUE值要进一步降到1.25以下,绿色低碳等级要达到4A以上。

所谓的PUE,简单点解释就是数据中心消耗的所有能源与IT设备能耗的比值,越接近“1”证明能效水平越好,也就说明数据中心的大部分电力都被服务器、网络设备、储存设备消耗掉了。但“PUE=1”只是理想情况,按照正常的物理逻辑,强悍的算力往往意味高耗、高热量。

首先就单个芯片来说,在制程不断突破极限、功率奔向千瓦时,如何冷却是头号问题。英特尔曾在1999年对外展示过一张折线图,内容是处理器功率密度随时间变化的趋势。可以很明确地看到,按照摩尔定律的发展路径,晶体管的尺寸和芯片的功率密度呈现负相关,也就是说晶体管尺寸减少的同时,芯片的功率密度反而高了。

而随着新的数据中心不断建设、装备了先进制程芯片的机柜投入使用,单个机柜的功率密度也在快速抬升。根据Uptime Institute发布的《2020全球数据中心调查报告》显示。2020年数据中心平均但机架功率为8.4(KW/机架),相比于2017年的5.6(KW/机架)、2011年的2.4(KW/机架)有明显提高,年复合增长率达到了15%。

而且短期来看,功耗问题难以顺利解决。因为在经典的冯·诺依曼架构中,数据的处理和存储是放在不同的地方,频繁地高速传输必然导致系统功耗很高。从某种角度理解,这也是冯·诺依曼架构的缺陷所在。所以,当全球媒体津津乐道AlphaGo打败人类时,有一组让人大跌眼镜的事实,人类只用了20瓦的大脑能耗,而AlphaGo的能耗达到了2万瓦。

先进制程芯片的突破、功率更高的单机柜使用,迫使数据中心使用更多的能源用于散热。

03

液冷技术成为破局要素

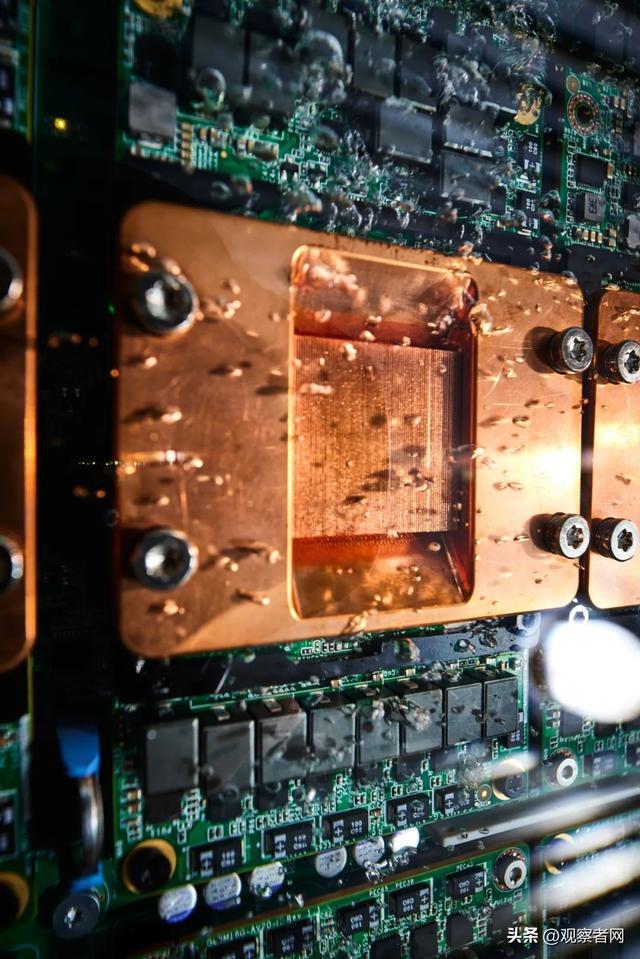

2022年,《求是》杂志第二期中的一张图片,吸引了众多通信界人士的目光。这张图片展示的是一款浸泡在液体中的处理器,在其周围附着了很多移动的气泡。在图片旁边还注明了一行文字:“对数字经济对经济社会的引领带动作用日益凸显,图中液冷计算节点能够将数据中心能效比PUE降至1.1以下,比传统风冷技术节电20%。”

实际上,这款图展示的正是曙光自主研发的浸没式相变液冷技术,通过特殊的、沸点很低的液体,将CPU、内存、电源系统等发热部件运行时产生的热量带出设备,之后这些液体再与水做热交换,最终将热量排除,达到给数据中心降温的效果。从具体的数据来看,这样的冷却技术达到了极好的效果,甚至能将PUE值控制最低1.04,这说明数据中心的电力基本很少有浪费。而且,这些液体带出的热量还能被回收,供附近居民采暖。

在液冷技术上,曙光很早就开始埋头耕耘。2011年,在业内竞相追逐互联网泡沫时,曙光开始了服务器液冷技术的探索与研究,2013年推出首台冷板液冷服务器原理机,并在一年后完成产品化。有了冷板液冷经验,先进的浸没相变液冷技术也就手到擒来了。2013年,首台浸没相变液冷原理验证机被推出,2014年原型机诞生,2017年启动商用,两年后,国内首个浸没相变液冷服务器大规模应用项目落地。

在东数西算的大背景下,曙光的绿色算力方案也在有序的落地中。在全国一体化算力网络成渝枢纽节点内,曙光在重庆市璧山区科学城打造的数据中心,就是以浸没相变液冷技术为底座,布局建设。实际上,依托液冷技术,曙光的绿色大脑正在为国内各地、各行业提供算力,相比传统风冷技术,一年节电量达2亿度。

由曙光承建西部(重庆)科学城先进数据中心效果图

基础设施意味着普惠性、大众化,也就意味着东西便宜、用的人多。18世纪的蒸汽、19世纪的电力、20世纪的宽带,都在相应的时间节点上,顺利地演变成那个时代的基础设施,有的仍存延至今。在以液冷技术为代表的绿色算力席卷全球、贯通各行各业时,我们似乎看到了强人工智能时代的算力基础设施,正呼之欲出。

来源|科工力量

相关文章

猜你喜欢