编辑:编辑部

【新智元导读】图灵奖得主Yoshua Bengio联合19人团队发布88页论文,论证了人类要想构建有意识的AI系统,是完全有可能的。人工智能发展到现在,到底有没有意识?

图灵奖得主Yoshua Bengio,联合19人团队跨界发表了一篇88页巨作,得出结论:

人工智能目前没有意识,但是以后会有。

论文地址:https://arxiv.org/pdf/2308.08708.pdf

具体来说,目前的人工智能系统都不具备意识,但人类想要构建有意识的人工智能系统,并不存在明显的障碍。

这篇论文一经发表,引来了诸多大佬关注。

马库斯表示,我们真的「想」制造有意识的机器吗?我完全不确定这是不是个好主意。

可以说,这篇论文应该是对AI是否具有意识这一争议话题最为权威和客观的解答。

人工智能中的意识

由于团队认为AI在未来几十年之内可能会表现出意识,因此希望建立一个客观的标准来追踪这个过程的发展。

研究方法

研究方法研究人员首先需要对意识的客观存在设置一套具体可以评估的标准:

在他们看来,研究的评估方法是基于以下3个原则和理论:

1. 计算功能主义:实现某种计算对于意识来说是必要且充分的,因此原则上非有机人工系统有可能具有意识。

2. 科学理论:神经科学的研究在意识存在的必要和充分条件方面取得了进展,研究将基于这些神经科学理论展开。

3. 着重理论的研究方法:研究人工智能系统是否可能有意识的一种方法,是去评估它们是否满足从科学理论中得出的功能或架构条件,而不是寻找某些具体的行为特征。

于是,研究人员首先介绍了研究展开的基础——计算功能主义。

该理论认为,人脑由多个专门的子系统或模块组成,可以并行地进行各自的信息处理。 这些模块需要某种机制来统合信息,以协调配合。

「全局工作空间」就是这样一个信息共享和融合的平台。一个信息如果进入这个工作空间,就可以被所有的模块访问。

接受过物体分类训练的DCNN对局部形状和纹理的敏感度高于对整体形状的敏感度,而且往往会忽略物体各部分之间的关系,这表明DCNN并未采用综合场景的表征。

最近也有其他研究发现,图像生成模型DALL-E 2在生成一个以不熟悉的方式排列物体的场景时表现不佳。

总结起来,从RPT的角度来看,有关模型能够对视觉刺激的特征进行分类,据说这种功能在人类中是在无意识的情况下执行的,但却不能执行进一步的功能,包括生成有组织的、综合的视觉场景表征,其中有些可能需要意识。

然而,目前的其他系统,包括预测编码网络,确实可以执行其中一些进一步的功能。

AI实现GWT指标指标GWT-1规定,系统必须有能够并行工作的专用系统或模块。为实现全局广播,这些模块必须由递归神经网络实现,除非它们是整个系统的「输出」模块,不向工作空间提供信息。这些模块的输入可能是:

1. 一种或多种模式的感官输入。

2. 少量其他模块的输入,这些模块通常协同工作。例如,「囊状视线」模块可能会从「视觉突出」模块获取输入,以便快速自下而上地对潜在的重要物体进行囊状视线。

3. 来自「全局工作空间」执行模块的自上而下的信号。

这些模块可以针对狭小的任务进行独立训练。或者,它们也可能与工作空间一起进行端对端联合训练,以实现某些全系统目标。子任务的模块专业化也就自然而然地产生了。

在这种情况下,广播机制可能包括一个动力学缓慢的泄露神经整合器,以至于需要持续的输入来将其置于特定状态。在缺乏这些持续输入的情况下,它会回到某种基线状态(就像基于证据累积的决策模型中一样)。这种广播机制将生成馈送到每个专门模块的自上而下的信号。

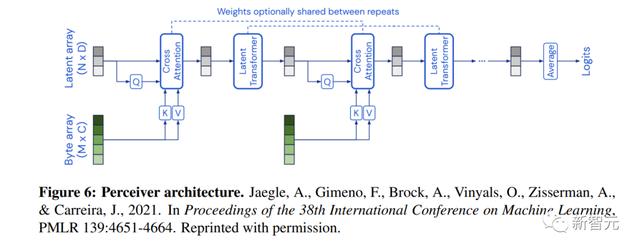

指标GWT-4包括系统必须使用状态相关的注意机制,并且工作空间必须能够通过连续的查询组合模块以执行复杂任务。

对于状态相关的注意机制,之前有两项研究都提出了使用键-查询注意机制,这在当前的AI模型中很常见。

在这种情况下,查询任务可以从工作空间的当前状态中计算出来,而所有其他模块都可以计算出键。

工作空间查询与特定模块的键之间的相似性将通过所有其他模块之间的相似性进行归一化,以引入模块之间的竞争。这些归一化的相似性将决定每个模块的值对工作空间的净输入的贡献程度。

换句话说,标准的键-查询注意机制将在每个时间点应用于计算工作空间的输入,这取决于其当前状态。

所描述的模型将能够满足GWT-4的第二部分,即通过时间展开,使用工作空间连续查询模块以执行复杂任务的能力。

由于工作空间和模块之间存在计算循环,当模型在时间上展开时,这种能力将会显现出来。虽然模块从自下而上的感觉输入和少量其他模块接收输入,但它们也从工作空间接收自上而下的输入。

这意味着,例如,一个模块可以通过控制工作空间中的内容来控制其他模块。工作空间通过连续招募模块在系统的计算能力范围内,因此如果在训练过程中有益,这种连续招募的能力可能会出现。

然而,这样的系统需要适当的训练,以便学习如何以有意义的方式组合模块并执行复杂任务。构建适当的训练方案可能是实施GWT的一个重要挑战。

AI实现PRM指标HOT-4指出系统必须具有稀疏且平滑的编码来生成「质量空间」。事实上,有证据表明,当前DNN学习的感知表示空间已经与人类视觉系统的感知表示空间非常相似,这意味着它们相应的「质量空间」可能已经基本对齐。

指标HOT-1和HOT-2表明模型必须包含感官数据的一阶感知表示和为特定一阶表示分配可靠性或「真实性」度量的高阶表示。为了满足这些条件,大量已知的深度学习解决方案都是可能的。

(一阶)神经网络将传感数据和/或自上而下的信号作为输入,并产生分布在层次结构中的许多感知表示。并行的层(2),一系列单独的(高阶,特别是二阶)神经网络,每个神经网络都将一阶层的激活作为输入,然后输出一个标量,表示该层的一阶表示的概率是真实的。

满足条件的解决方案主要在二阶网络的训练方式方面有所不同。

如果偶尔存在监督信号,为二阶网络提供有关一阶表示可靠性的「基本事实」,则可以训练二阶网络以通过标准监督学习来估计正确性的概率。获得这个真实信号可能很困难,但并非不可能。

AI实现ASTWilterson和Graziano在他们的研究中提出的AI系统,在每层200个神经元的三层神经网络上使用强化学习来学习接住落在不可预测路径上的球。

这个非常简单的AI系统确实能实现指标属性AST-1的一部分,即注意力模式,因为它使用类似注意力机制的表示来控制该机制,从而提高了性能。

另一项研究测试了在多智能体强化学习任务上采用键-查询-值注意的几种不同系统。他们的系统涉及三个主要元素:注意力层、用于「内部控制」的循环神经网络和策略网络。

在他们最准确地实现注意力模式的版本中,注意力层被应用于系统的输入,并将信息发送到生成动作的策略网络,内部控制网络都学习预测注意力的行为层并影响这种行为。该系统的性能优于其他系统,其不同的架构由相同的组件组成,并在多智能体强化学习任务上进行了测试。

AI实现代理和具身化

剩下的指标是代理性和具身化。正如研究人员所描述的那样,强化学习对于代理来说可以说是足够的(「从反馈中学习并选择输出以追求目标」),因此满足指标AE-1的这一部分可能非常简单。

指标AE-1的第二部分表示,如果系统表现出「对竞争目标的灵活响应」,意识的可能性就会提高到更大程度。激发该条件的例子是平衡多种稳态驱动的动物:这需要对环境变化敏感的优先顺序。

在此项研究中的实施指标AE-2指出系统应该使用输出输入模型(也称为前向模型)进行感知或控制。

但是学习与感知和控制相关的任务的输出输入模型很常见,但当前满足这些具体描述的人工智能系统的例子很少。

Transformer实现GWT的案例研究在实践中,某个具体的AI系统是否具有意识某一项指标属性并不好判断。一是研究人员没有对每一项指标给出绝对精确的定义。

另一个原因是深度学习系统的工作方式,包括它们在中间层所代表的内容,通常是不透明的。

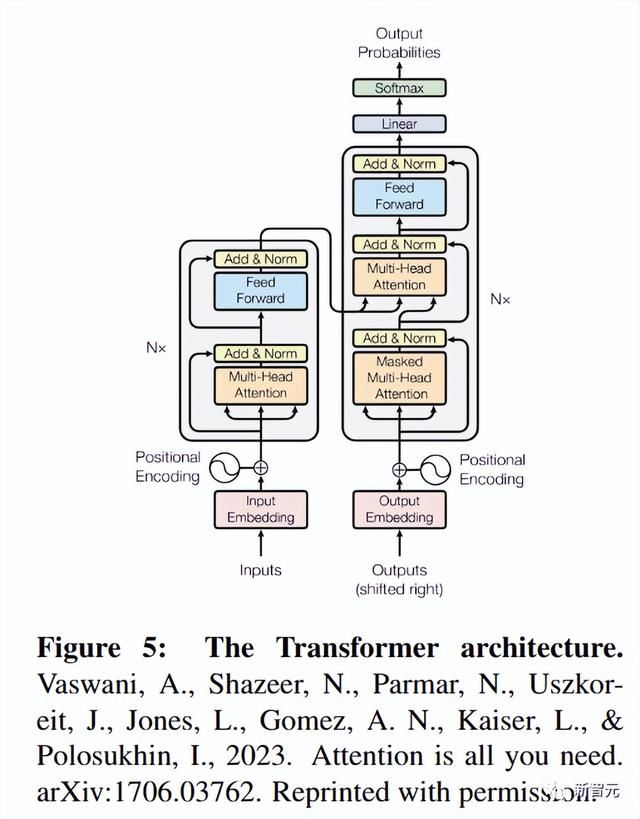

在Transformer中,一种称为「自注意力」机制用于整合来自输入不同部分的信息,这些部分通常位于序列中的位置。

如果研究人员将处理来自每个位置(注意力头)的信息的系统元素视为模块,那么Transformer架构和全局工作空间之间存在基本相似之处:都集成来自多个模块的信息。

Transformer由两种类型的层组成,这些层交替出现:注意力层(执行自注意力操作、在位置之间移动信息)和前馈层。

考虑到残差流的概念,可以认为Transformer拥有指标属性GWT-1到GWT-3,即它们具有模块、容量有限的工作空间引入了瓶颈,并且全局广播。

存在「全局广播」,即残差流中特定层中的信息可以被下游注意头用来影响任何位置的进一步处理。

添加到给定层残差流的信息还取决于较早层残差流的状态,因此根据这种解释,人们可能会认为Transformer满足GWT-4中状态相关的注意力要求。

Transformers缺乏具有全局工作空间的系统的整体结构,因为没有一个独特的工作空间集成其他元素。

基于Transformer的大型语言模型几乎没有拥有任何GWT派生的指示符属性。

对AI是否有意识的错误认知的影响

过度漠视AI存在意识的可能性:在人类意识到AI具有意识之前,就已经让他们承受了过多的痛苦。人类对AI的使用可能就会像虐待动物一样造成道德风险。

除非能够构建有意识地去承受痛苦的AI,才可能阻止它们承受痛苦,避免这种道德风险。

过度认为AI具有意识:另一方面,人类也很有可能过度地认为AI具有意识——事实上,这似乎已经发生了——也存在与此类错误相关的风险。

最直接的是,当我们的努力更好地致力于改善人类和非人类动物的生活时,我们可能会错误地优先考虑人工智能系统的感知利益,从而导致资源分配的问题。

其次,如果我们判断一类人工智能系统是有意识的,这应该导致我们以不同的方式对待它们——例如以不同的方式训练它们。

原则上,这可能与确保人工智能系统以造福社会的方式开发的工作发生冲突。第三,过度归因可能会干扰宝贵的人际关系,因为个人越来越多地转向人工智能来进行社交互动和情感支持。这样做的人也可能特别容易受到操纵和剥削。

参考资料:

相关文章

猜你喜欢