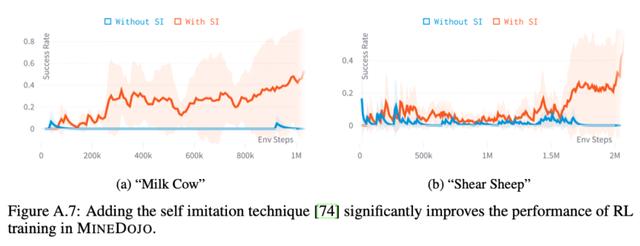

由于RL收敛比较慢,作者也采用了不少方法加速训练,其中很重要的一点是Self-Imitation Learning,直接把拿到高奖励的动作序列保存下来去学习,就像SFT一样去学习,效果提升很明显(红色线):

我特意查了一下VPT作者,并没有人参与InstructGPT,不知道两个项目是否有交流,但不少VPT的作者在简介里都说了自己正在参与语言大模型的工作。

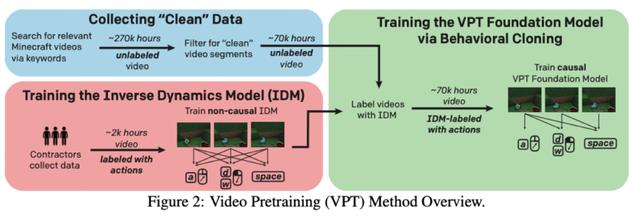

只能说OpenAI把这套范式玩明白了,训什么都用这个思路。但其中有个难点,就是预训练的时候视频数据没有自监督信号,因为模型要输出的是动作,而不是下一个画面。

于是他们想了一个简单粗暴的解决办法,就是先让标注人员去玩游戏,记录他们的游戏画面和对应的动作(键盘、鼠标),再用这批数据训练一个模型(Inverse Dynamics Model),去给所有的视频数据预测出标签。这样就可以进行自回归视频预训练了。预训练的数据量是70k小时的视频,大概5B的token,模型参数量在0.5B。

得到视频预训练模型之后,对于特定的任务,可以直接利用人工标注数据进行精调,同时可以再进行RL,作者发现Pretrain SFT RL三步之后效果奇佳,模型可以完成非常复杂的任务(人类需要20分钟才能完成)。

同时,VPT也尝试了加入字幕、音频转文字后的数据进行多模态训练,但由于数据太少,只展现了微弱的可控性,不过当下再来看文本可控并不是难点,已经有很多成功的工作了。

看完VPT,再来对比一下MineDojo,可以发现LLM范式一个明显的优点,即提升了训练效率和效果天花板,因为纯RL要靠自己探索,其实收敛的很慢,而且有些复杂的任务需要很长的链路,纯RL可能根本探索不到。

通用视频预训练?

虽然VPT证明了LLM的范式在视频预训练同样可行,但个人认为还有两个比较关键的问题:

图像与文本的预训练数据不兼容:目前互联网的语料都是图像或者文字一方占主导,所以后续大概率是和现在一样,两种模态分别预训练,再通过少量数据融合。

VPT的方法不够通用:像NLP一样进行通用领域的视频预训练还有很长的路要走。首先VPT在准备训练语料时,需要定义标签的动作空间,目前只局限在鼠标和键盘,但真实世界中的动作太多了;另外很多领域的监督数据也不一定好获取,比如需要真人出镜的视频成本会很高。

VPT这篇工作在去年推出时并没有引起太大火花,如今想一想,虽然存在上述问题,但在一些垂类场景上已经有落地的可能了,比如在excel上做数据分析、做PPT、操作photoshop等。

再一想,OpenAI居然前年就开始做这些事儿了,真可怕。

参考资料[1]Video-Pre-Training: https://cdn.openai.com/vpt/Paper.pdf

[2]MineDojo: https://minedojo.org/

相关文章

猜你喜欢