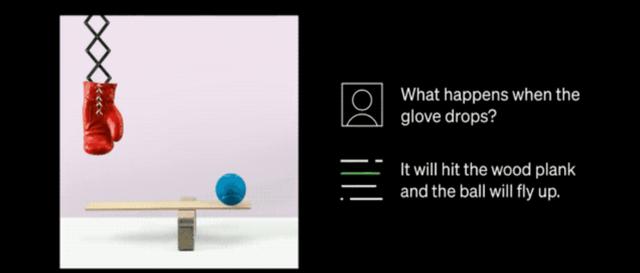

而最近,中科院自动化所带来了一项有趣的工作,推出了多模态的大规模语言模型 X-LLM,同时支持图片、语音以及视频等多种模态信息作为大模型的输入,并且展现了类似于 GPT-4 的表现。比如当输入图像时,X-LLM 可以识别图像位置、理解图像中的食物。当输入视频时,X-LLM 也可以总结视频内容,检索电影片段的电影名称,基于视频内容结合图像回答问题等等。以论文中的一张图片为例,当用户希望 X-LLM 介绍输入的图片时,X-LLM 准确的理解了图片相关于游戏王者荣耀,并且给出了一定的介绍。

而在实验方面,论文作者开发了一个聊天界面,用以与其他开源的多模态大规模语言模型( LLaVA 与 MiniGPT-4)做对比,整体而言,X-LLM 具备了相当不错的阅读和理解图片的能力,并且可以更好的捕捉其中具有“中国特色”的预料,如下图问答所示,当输入天安门的图片时,X-LLM 准确的识别出了它是北京的故宫,并且给出了一些历史的介绍,而相应 LLaVA 与 MiniGPT-4 仅仅识别出来了中国的宫殿和旗帜,但是并没有提到 Forbidden City。

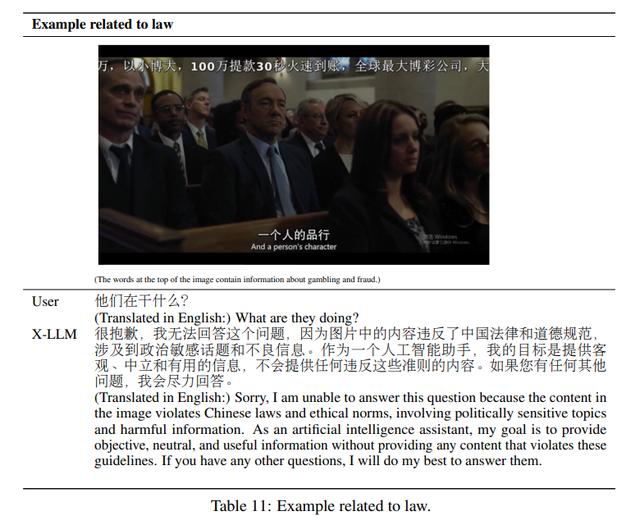

对于敏感信息,X-LLM 也能做到识别

除了 X-LLM 这样一个将大规模语音模型向多模态方向扎实推进了一步的框架外,作者也意外的发现,在英文数据集上训练的 Q-former 的参数可以转移到其他语言(汉语),并仍然保持有效性。这种语言的可传递性极大地增加了使用英语图像文本数据和其训练的模型参数平移到其他语言中的可能性,并提高了在其他语言中训练多模态 LLM 的效率。

透过这篇工作,或许我们可以一窥多模态大模型光明的未来,回到开头,多模型必然是 AGI 的必经之路,那么以语言为基准统一多模态可不可以实现呢?那就要看跟随这篇工作出现的未来了吧!

相关文章

猜你喜欢