机器之心专栏

机器之心编辑部

AI 造假的成功率很高,前几天「10 分钟骗 430万」还上了热搜。在最热门的大语言模型上,研究人员最近探索了一种识别方法。

随着生成式大模型的不断进步,它们生成的语料正逐步逼近人类。虽然大模型正在解放无数文书的双手,它以假乱真的强劲能力也为一些不法分子所利用,造成了一系列社会问题:

由这些例子可见,很难对 AI 生成的简短回答进行识别:这类语料与人的区别过小,很难严格判断其真实属性。因此,将短文本简单标注为人类 / AI 并按照传统的二分类问题进行文本检测是不合适的。

针对这个问题,本研究将人类 / AI 的二分类检测部分转化为了一个部分 PU(Positive-Unlabeled)学习问题,即在较短的句子中,人的语言为正类(Positive),机器语言为无标记类(Unlabeled),以此对训练的损失函数进行了改进。此改进可观地提升了检测器在各式语料上的分类效果。

算法细节

在传统的 PU 学习设定下,一个二分类模型只能根据正训练样本和无标记训练样本进行学习。一个常用的 PU 学习方法是通过制定 PU loss 来估计负样本对应的二分类损失:

通过理论推导和实验,估计得到先验概率随着文本长度的上升而上升,最终逐渐稳定。这种现象也符合预期,因为随着文本变长,检测器可以捕捉的信息更多,文本的 「来源不确定性」也逐渐减弱:

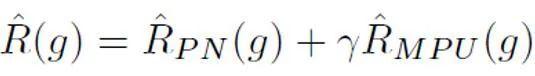

之后,对于每个正样本,根据其样本长度得到的独特先验对 PU loss 进行计算。最后,由于较短文本仅有部分 “不确定性”(即较短文本也会含有一些人或者 AI 的文本特征),可以对二分类 loss 和 MPU loss 进行加权相加,作为最终的优化目标:

如上表所示,作者先在较短的 AI 生成语料数据集 Tweep-Fake 上检验 MPU loss 的效果。该数据集中的语料均为推特上较为短小的语段。作者又在传统的语言模型微调基础上将传统二分类 loss 替换为含有 MPU loss 的优化目标。改进之后的语言模型检测器效果较为突出,超过了其它基线算法。

如上表所示,作者在消融实验中观察了每个部分带来的效果增益。MPU loss 加强了长、短语料的分类效果。

作者还对比了传统 PU 和 Multiscale PU(MPU)。由上表可见 MPU 效果更胜一筹,能更好地适配 AI 多尺度文本检测的任务。

总结

作者通过提出基于多尺度 PU 学习的方案,解决了文本检测器对于短句识别的难题,随着未来 AIGC 生成模型的泛滥,对于这类内容的检测将会越来越重要。这项研究在 AI 文本检测的问题上迈出了坚实的一步,希望未来会有更多类似的研究,把 AIGC 内容进行更好的管控,防止 AI 生成内容的滥用。

相关文章

猜你喜欢