在今年的3月中旬,OpenAi在GPT-4的发布会上表示,在未来GPT-4的应用层中将加入“图片识别理解能力”,旨在让GPT-4更好地认知现实事物,同时结合LLMs的优势理解产出相关文字内容,这一功能看上去非常酷,但OpenAi迟迟没有让这一功能上线公测,就在大家都怀疑是OpenAi在画饼,在做“PPT产品”的时候,一款名为“BeMyEyes”的应用打了质疑者的脸。

GPT-4发布会上所提及的“GPT笑话理解图”

“BeMyEyes”是一款老应用了,于2015年发布,由丹麦开发人员HansJ?rgenWiberg创建。其是一款免费的移动端App,旨在帮助视力受损和盲人用户进行日常活动。这款应用充当视力受损人士与志愿者之间的桥梁,允许他们通过实时视频通话请求帮助。志愿者可以帮助解答各种问题,如阅读标签、识别颜色、找到物品等。

“BeMyEyes”官网介绍https://www.bemyeyes.com/

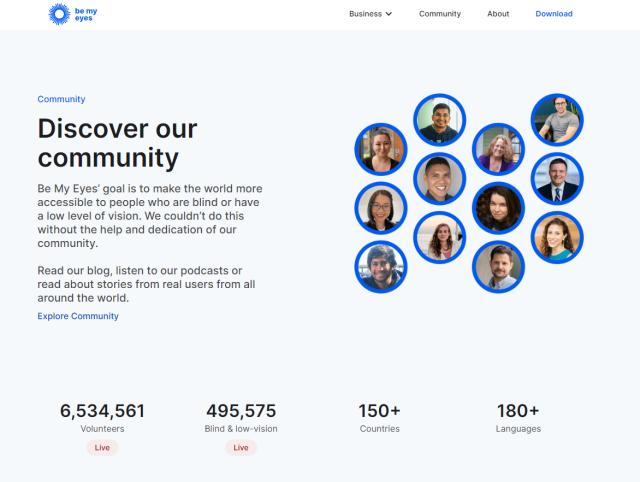

其充分利用了手机摄像头作为视觉障碍者的眼睛,如果某个志愿者收到请求却正忙于其他事情无法回应,该应用会自动将请求转发给其他可用志愿者,确保视力障碍用户能够第一时间得到帮助。截止2023年3月,该应用已经有了50万的视觉障碍者用户以及640万视力正常的志愿者,服务比高达12.8:1。

支持多达150个国家与180种语言,也支持中文

可是由于人与人沟通的心理压力障碍、交流障碍等种种原因,部分视觉障碍者还是没有接受该软件的解决方式,认为使用“BeMyEyes”意味着与陌生人共享个人信息和生活场景。这可能让一些视力障碍者感到危险,担心自己的隐私和安全。同时,部分视力障碍者可能会认为向他人寻求帮助会降低他们的自尊。他们可能觉得,通过应用程序请求帮助意味着承认自己的弱点和不足。

Ai绘画丨孤独沮丧的盲人

这些因素让“BeMyEyes”的推进遇到了瓶颈,直到Ai的火爆。在2022年GPT-3.5模型发布之时,其强大且难以置信的理解力就震惊了全世界,这个将人类2021年9月前的所有文明当作自己数据库的LLMs(大型语言模型),拥有着史无前例的Ai创造力。

“BeMyEyes”的创造者Wiberg在2023年2月就与OpenAi接洽,获得了GPT-4模型中的“图像理解生成技术”,通过该技术其推出了一项名为“虚拟志愿者”的新功能,该功能由OpenAI的GPT-4语言模型驱动。通过整合GPT-4的图像识别和文字生成技术,虚拟志愿者可以为视力障碍者提供更为深入的实时视觉辅助。用户可以通过应用发送图片,虚拟志愿者会对图片进行解析,并提供相关信息帮助。

“BeMyEyes”官网介绍https://www.bemyeyes.com/

从原理上讲,GPT-4模型实现图片理解功能的关键在于其图像识别和文字生成技术。首先,模型接收到用户上传的图片,对图片进行分析和识别,提取关键信息。在这一过程中,模型需要具备对不同物体、颜色、形状和场景的识别能力。然后,模型将识别到的信息转换为自然语言描述,与用户的问题相结合生成有针对性地回答。在此阶段,模型需要理解上下文信息并具备良好的对话能力,以便生成有用的建议和指导。

图片源自于网络

到目前为止,她用这款工具帮助她阅读时尚目录,将中文成分翻译成英文,搜索网上食谱,为她自己的照片库中的图片编写代替文字,还帮助她阅读餐厅菜单。Edwards还展示了将虚拟志愿者用作私人教练和伦敦地铁导游的潜力。

Ai绘画丨一个机器人正在帮盲人过马路

相关文章

猜你喜欢