贾浩楠 发自 凹非寺 量子位 报道 | 公众号 QbitAI

2020年的最后一天,来回顾一下今年所有AI顶会的最佳论文吧!

今年,顶会的最佳论文,既有ECCV的“2D变3D”的NeRF,当然,也有今年引起轰动的GPT-3,它来自NeurIPS 2020。

而ICRA、ACL、AAAI等等,顶会,把最佳论文给了较为基础的理论研究。

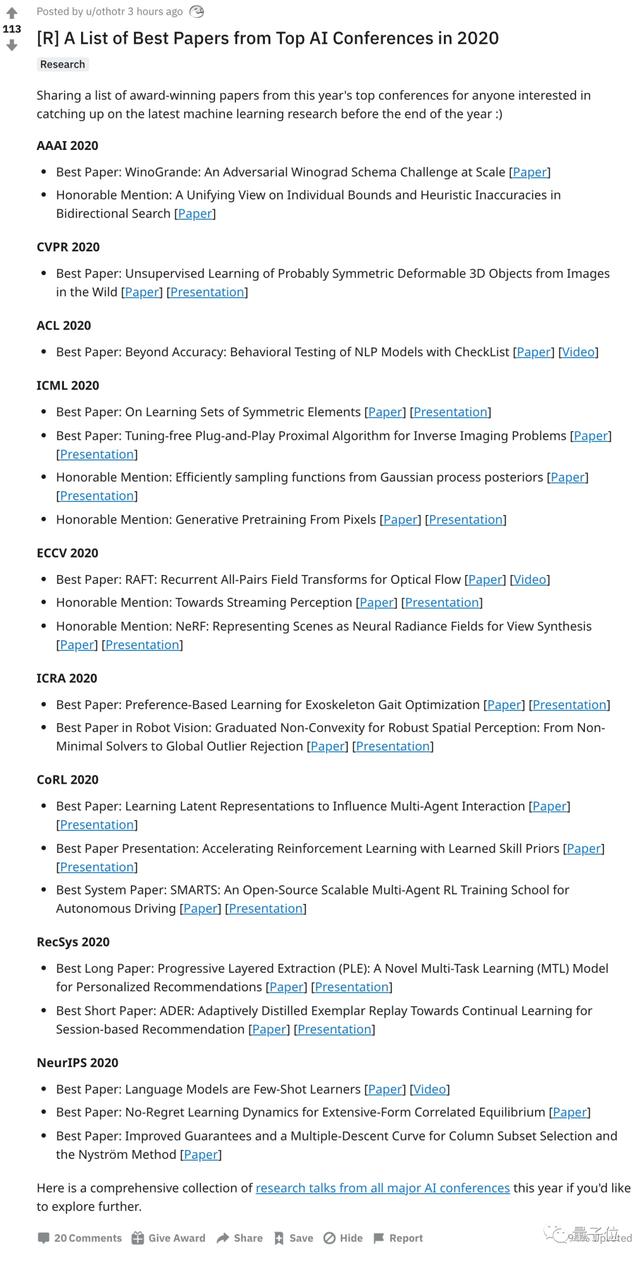

Reddit上,有网友整理汇总了今年AI顶会的最佳论文:

首先描述了线性层的空间,这些线性层对元素重排序和元素的固有对称性(如图像中的平移)都是等价的。

由这些层组成的网络,称为对称元素的深集(Deep Sets for Symmetric Elements,DSS)层,是不变函数和等价函数的通用近似器。

在一系列的图像、图形和点云的实验中表明,DSS比现有的学习架构有所改进。

Tuning-free Plug-and-Play Proximal Algorithm for Inverse Imaging Problems

Plug-and-Play (PnP)是一个非凸框架,它将近端算法,例如乘法器的交替方向法(ADMM),与先进的去噪器前导相结合。

PnP方法的一个关键问题是需要手动调整参数。

本文提出了一种免调整的PnP近端算法,它可以自动确定内部参数,包括惩罚参数、去噪强度和终止时间。

实验证明,学习到的策略可以针对不同的状态定制不同的参数,而且往往比现有的手工制作的标准更加高效和有效。

ECCV 2020最佳论文:RAFT: Recurrent All-Pairs Field Transforms for Optical Flow

本文提出了RAFT,一种新的光流深度网络架构。

RAFT提取每个像素的特征,为所有像素对建立多尺度的4D相关卷,并通过对相关卷进行查找的循环单元迭代更新流场。

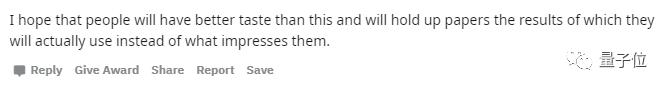

有网友甚至认为,AI顶会,评委们的评选标准,实在是不科学。

他认为,今年的这些论文,当然都是质量很高的论文,但是,除了GPT-3以外,其他文章都是应用类结果,不是真正的通用机器学习进展。

评委们的“品味”应该更高一点,最佳论文应该是结果能真正使用在后续研究中,而不是仅仅给人留下深刻印象。

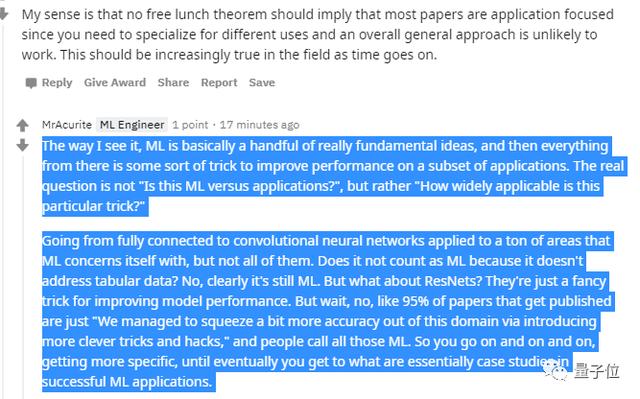

而反对意见认为,评判一篇论文价值,要问的问题不是 “这是机器学习还是应用?”,而是 “这个特定的技巧有多广泛的适用性?”

这一观点立刻引来反驳。

Transformer是到处都在使用的通用机器学习模型,当然算机器学习范围。

这种观点中所说的到处,是指CV、NLP、计算积分的分析表达式等各个领域。

但是,有人指出,在工业界,极少应用大规模Transformer,因为工业模型太庞大,数据太复杂,算力根本跟不上。

所以,大规模Transformer要想应用在工业领域,还需要进一步优化结构,当然,还要更好更贵的卡。

怎样?你认为GPT-3算是算法创新吗?

— 完 —

相关文章

猜你喜欢