为了证实 GPT-3 对人们写作和阅读方式可能带来的影响,前不久,来自加州大学伯克利分校的学生 Liam Porr 做了一项实验。

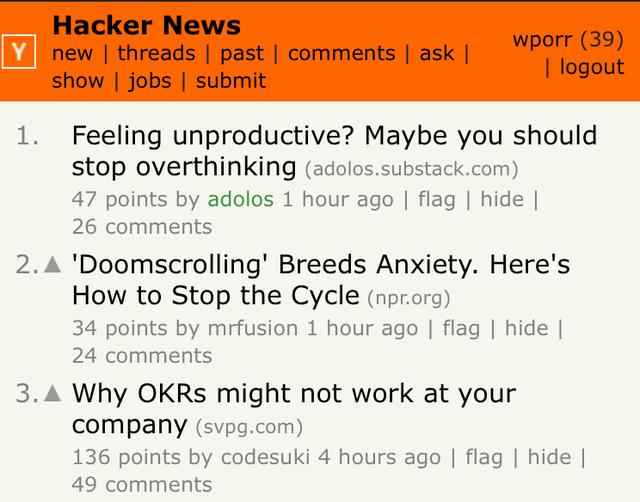

他以 Adolos 为笔名开通博客,在其中发布由 GPT-3 模型生成的文章,第一篇就被顶至 Hacker News 头条,还被 medium 等各大平台转载,该博客迅速获得了 60 位关注者及大约 2.6 万访问量。但注意到文章是由人工智能生成,且提出质疑的人屈指可数。

实际上,Porr 本人仅指定了标题和简介,其他内容都交由 GPT-3 完成。他发现,GPT-3 不擅长逻辑和理性,但能够创造漂亮的语句。这样的文章经不起仔细推敲,可并不妨碍仍有大量人喜爱阅读它们,往往只要抛出一个受欢迎的话题就足够。

GPT-3 被认为是迄今为止最大的 AI 语言模型,由 1750 亿个参数组成。这是一个史无前例的庞大语言模型,几乎所有可以用文字表达的工作它都能胜任,可以指导它回答问题、写文章、写诗歌、甚至写代码。

其背后的开发者 OpenAI 目前仅开放了少量 GPT-3 的 API 测试资格,Porr 通过伯克利 AI 社区找到了一位具有资格的博士生进行合作。从产生这个想法,到利用 GPT-3 生成具有病毒式传播潜力的文章,Porr 仅用了短短几个小时。而在此之前的一周内,他还不了解 GPT-3 为何物。

实验持续了两个星期,最终结束于 Adolos 博客发布的最后一篇文章《若我没有道德,会拿 GPT-3 来做什么》,文章指出“滥用这项技术的方法比制造纳粹宣传还要微妙得多”。当然,这篇文章由 GPT-3 生成还是由人类撰写也是一个谜。

Porr 本人最后在自己的博客中解释了整个实验过程,除了对当前网络内容质量和人们分辨能力的警醒,他还提出了 GPT-3 这类技术对媒体机构可能产生的影响。他认为,即便能够大幅降低人力成本,传统的老牌媒体仍然会因专业性对其感到抵触,而新媒体也许会从中获得施展空间。

关于 GPT-3,也可阅读:人类算力天花板?1750 亿参数的 AI 模型 GPT-3 引爆硅谷

相关文章

猜你喜欢