Pine 发自 凹非寺

量子位 | 公众号 QbitAI

ChatGPT的热度稍有平息,蛰伏已久的Meta就迅速放出“大招”:

一次性发布四种尺寸的大语言模型LLaMA:7B、13B、33B和65B,用小杯、中杯、大杯和超大杯来解释很形象了有木有(Doge)。

还声称,效果好过GPT,偏向性更低,更重要的是所有尺寸均开源,甚至13B的LLaMA在单个GPU上就能运行。

消息一出,直接在网上掀起一阵热度,不到一天时间,相关推文的浏览量就已经快破百万。

而这把开源,也不只利好开发人员,同样也利好Meta。

LLaMA模型也有着其他大语言模型的通病:会产生偏见性、有毒或者虚假的内容。开源吸引来的更多的研究可以帮助解决这个问题。

不过讲了这么多,Meta的这个LLaMA模型到底能做啥?

扎克伯格直接在Facebook放出豪言,这是AI大语言模型里的新SOTA:

生成文本、进行对话、总结书面材料以及解决数学定理或预测蛋白质结构等它都能干。

编程、写小说也是分分钟的事儿:

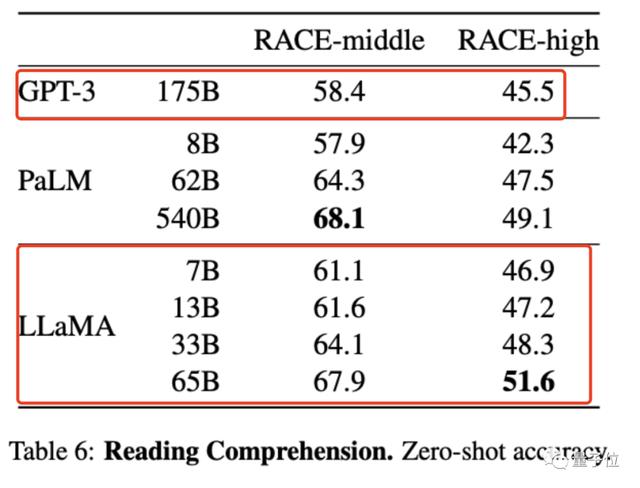

又比如说阅读理解:

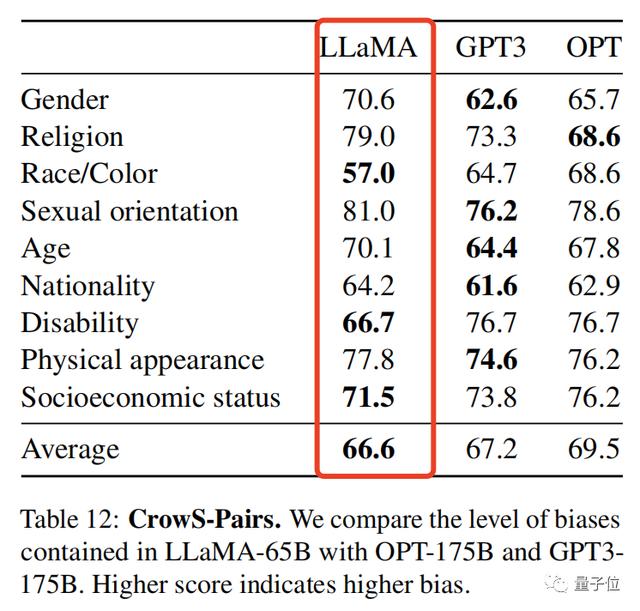

甚至,研究人员还提供了一组评估模型偏见性和毒性的基准,得分越高,偏见就越大:

LLaMA以66.6分险胜,偏见性略低于GPT-3。

你对Meta这次的LLaMA怎么看呢?如果还想了解更多可以戳文末链接~

论文地址:https://research.facebook.com/publications/llama-open-and-efficient-foundation-language-models/参考链接:[1] https://ai.facebook.com/blog/large-language-model-llama-meta-ai/[2] https://twitter.com/GuillaumeLample/status/1629151231800115202[3] https://twitter.com/ylecun/status/1629243179068268548

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态

相关文章

猜你喜欢