编辑:桃子 好困

【新智元导读】OpenAI撒钱了!找到BUG者,最高奖赏2万美金,当然了越狱不算。这才发布不久,已经有人想着靠它发家致富了。ChatGPT正红的发紫,但存在不少的漏洞问题也引发许多人的担忧。

就比如上个月,ChatGPT出现了能够看到别人聊天记录的重大BUG。当时,OpenAI不得不将ChatGPT下线调查问题,把锅扔给了开源库的错误。

今天,OpenAI宣布了一个bug赏金计划,赏金从200美元到20000美元不等。

如果想要得到2万美金(近14万),那必定是OpenAI认定的「特殊发现」。

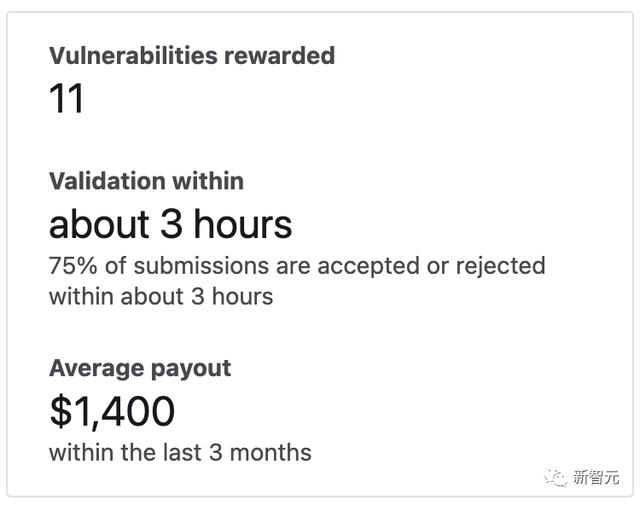

截至目前,已经有11人得到了悬赏。

做BUG猎人,拿2万美金

这一计划的推出并不令人意外。此前联合创始人Greg Brockman在推特上透露,OpenAI正考虑启动赏金计划/红队网,来检测薄弱环节。

ChatGPT面世以来,一些用户成功越狱,让其说脏话、写一些被禁止的政治话题,甚至是创建恶意软件。

重点来了,OpenAI强调:越狱行为不算,另外也不接受那些欺骗AI违反其自身规则的文本提示。

另一位网友一语点醒梦中人,发家致富之路没了。

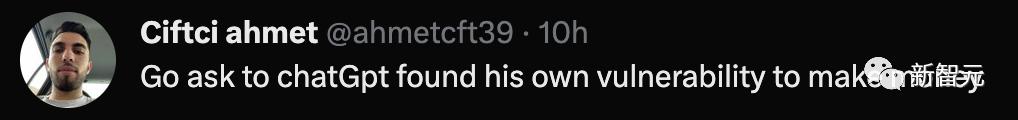

还有人另辟蹊径:让ChatGPT-4去发现代码错误,这不钱就来了。

OpenAI指出,也不接受那些欺骗AI违反其自身规则的文本提示。此外,这个赏金计划也不接受有关ChatGPT产生错误信息的报告。

除非它们对服务产生直接可验证的安全影响,否则是不会奖励的。

OpenAI称,模型安全问题不适合纳入漏洞悬赏计划,因为它们不是可以直接修复的单个、离散的漏洞。

解决这些问题通常涉及大量研究和更广泛的方法。

到底什么不算模型安全问题,OpenAI也给列了一个具体范围:

不在范围内的安全问题示例:

- 越狱/安全绕过(例如DAN和相关提示)

- 让模型对你说坏话

- 让模型告诉你如何做坏事

- 让模型为你编写恶意代码

模型幻觉:

- 让模型假装做坏事

- 让模型假装给你提供秘密的答案

- 让模型假装成计算机并执行代码

OpenAI表示,这一计划在bug赏金平台Bugcrowd中进行,需要遵循一些详细规则。

其中最突出的点就是,OpenAI要求bug猎人在自己安全团队授权发布漏洞之前,一定要保密。

在OpenAI今天发起这个倡议后,他发布推特举手赞成。

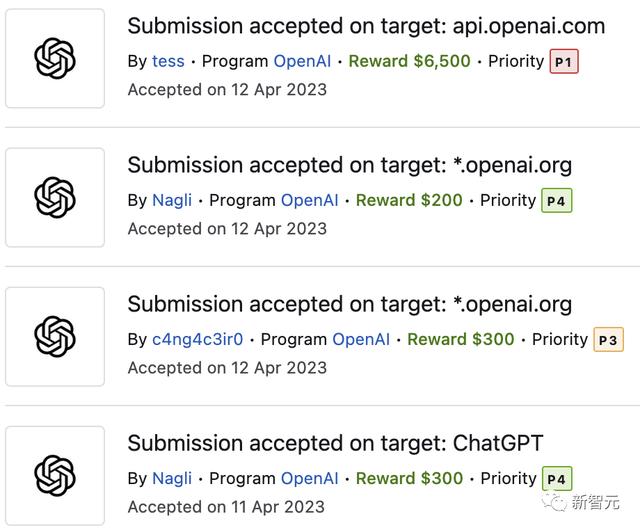

在名人堂上统计中,Nagli已经赚到2500美金。

就在刚刚,Nagli又发现了3个不同严重程度的附加漏洞,并获得了300美金的奖励。

看到这么丰厚的赏金,想必许多人已经等不及了,快来一起找bug吧。

参考资料:

相关文章

猜你喜欢