整理 | 屠敏

出品 | CSDN(ID:CSDNnews)

ChatGPT、GPT-3、GPT-4、text-davinci-003......近两年来,大模型层层出不穷,使人眼花缭乱,在不同的场景下,很多研究人员往往不知该作何选择?

为了解决这一难题,微软亚洲研究院和浙江大学的研究团队展开合作,发布了一个大模型协作系统——HuggingGPT,让 ChatGPT 与人工智能社区 HuggingFace 连接起来,将语言作为通用接口,让 LLM 作为控制器,管理行业内现有的所有人工智能模型。

「解决不同领域和模式的复杂人工智能任务是迈向 AGI 的关键一步」,研究团队在最新发布的 HuggingGPT 论文(https://arxiv.org/pdf/2303.17580.pdf)伊始说道。

写在最后

HuggingGPT 论文的发布引发了不少 AI 专家的关注,如果其正式落地,那么只需要通过 ChatGPT 一个入口就可以访问到各种适用的模型。

对此,英伟达 AI 科学家、斯坦福博士 Jim Fan 评价道:

HuggingGPT 是我本周阅读的最有趣的论文。它非常接近我描述的“Everything App”愿景。ChatGPT 充当 “AI 模型空间”的控制器,根据人类规范选择正确的模型(应用程序),并正确组装它们以解决任务。它是一种“低带宽”方式的多模态——所有模态都需要通过文本字符串进行压缩和连接。HuggingGPT 也与 Prismer 的想法有关:尽可能利用预训练的领域专家模型。有时少训练就是多做事!

为了更好地落地这个愿景,研究团队在 GitHub 上开源了它的基础代码(https://github.com/microsoft/JARVIS),且命名为“Jarvis”(贾维斯),供大家参考学习。

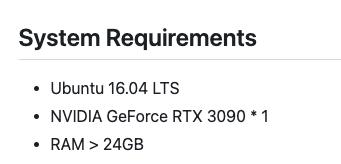

值得注意的是,很多网友直言,它的系统要求可能会直接劝退了不少人:

但是 HuggingGPT 也可以作为通往 AGI 的准入口。

https://github.com/microsoft/JARVIS

https://arxiv.org/pdf/2303.17580.pdf

相关文章

猜你喜欢