梦晨 发自 凹非寺量子位 | 公众号 QbitAI

专攻代码的Code Llama一出,大家伙都盼着谁来后续量化瘦身一下,好在本地也能运行。

果然是llama.cpp作者Georgi Gerganov出手了,但他这回不按套路出牌:

不量化,就用FP16精度也让34B的Code LLama跑在苹果电脑上,推理速度超过每秒20个token。

而最新爆料表示谷歌DeepMind联手开发的下一代大模型Gemini很可能也会用。

虽然OpenAI的具体方法都保密,但谷歌团队已经把论文发出来了,并且入选ICML 2023 Oral。

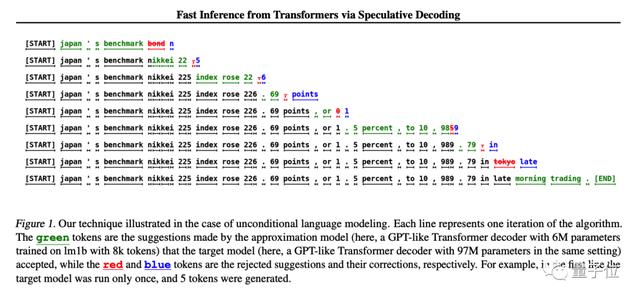

方法很简单,先训练一个与大模型近似、更便宜的小模型,让小模型先生成K个token,然后让大模型去做评判。

大模型接受的部分就可以直接用,大模型不接受的部分再由大模型修改。

在原始论文中使用T5-XXL模型演示,在生成结果不变的情况下获得了2-3倍的推理加速。

了解了原理,再来看Georgi Gerganov这次的具体设置。

他使用4bit量化的7B模型作为“草稿”模型,每秒约能生成80个token。

而FP16精度的34B模型单独使用每秒只能生成10个token。

使用投机采样方法后获得了2倍的加速,与原论文数据相符。

作者已创业

作者已创业作者Georgi Gerganov,今年三月LlaMA刚出一代的时候就移植到了C 上,开源项目llama.cpp获星已接近4万。

最开始他搞这个只是当成一个业余兴趣,但因为反响热烈,6月份他直接宣布创业。

新公司ggml.ai,主打llama.cpp背后的C语言机器学习框架,致力于在边缘设备上运行AI。

创业时获得来自GitHub前CEONat Friedman、Y Combinator合伙人Daniel Gross的种子前投资。

LlaMA2发布后他也很活跃,最狠的一次直接把大模型塞进了浏览器里。

谷歌投机采样论文:https://arxiv.org/abs/2211.17192

参考链接:[1]https://x.com/ggerganov/status/1697262700165013689[2]https://x.com/karpathy/status/1697318534555336961

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态

相关文章

猜你喜欢