本文来自DataLearner官方博客:总结一下截止2023年中旬全球主要厂商拥有的GPU数量以及训练GPT-3/LLaMA2所需要的GPU数量 | 数据学习者官方网站(Datalearner)

GPU Utils最近总结了一个关于英伟达H100显卡在AI训练中的应用文章。里面透露总结了一些当前的主流厂商拥有的显卡数量以及一些模型训练所需的显卡数。文章主要描述的是H1000的供应与需求,也包含H100的性能描述,本文主要总结一下里面提到的显卡数相关统计供大家参考。

H100简介以及常见的H100、GH200s、DGC GH200s、HGX H100s的区别GPT-4/Falcon等模型训练用到的GPU数量OpenAI、特斯拉等厂商拥有的GPU数量H100简介以及常见的H100、GH200s、DGC GH200s、HGX H100s的区别

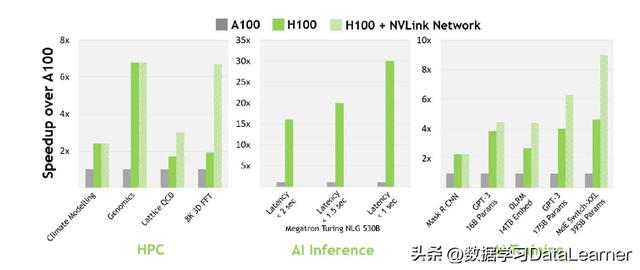

H100简介以及常见的H100、GH200s、DGC GH200s、HGX H100s的区别GPT-4/Falcon等模型训练用到的GPU数量OpenAI、特斯拉等厂商拥有的GPU数量H100简介以及常见的H100、GH200s、DGC GH200s、HGX H100s的区别首先还是简单介绍一下这里涉及到的显卡基本知识。H100是目前全球性能最高的专业级显卡,特别适合用来训练大语言模型这种超大规模参数的大模型。速度很快。在16-bit训练上,比A100快2.3倍,在16-bit的推理上比A100快3.5倍。

当然,与H100经常一起出现的还有H100s, GH200s, DGX GH200s, HGX H100s, 和 DGX H100s这些名称,其基本区别如下:

H100 = 一个H100 GPUHGX H100 = Nvidia 的服务器参考平台,OEM厂商可用其构建一个包含4块GPU或8块GPU服务器。由像Supermicro这样的第三方OEM厂商制造。DGX H100 = Nvidia官方的H100服务器,配备8个H100 GPU。Nvidia是唯一的供应商。GH200 = 1x H100 GPU加上1x Grace CPU。DGX GH200 = 256个GH200,预计于2023年末推出。很可能仅由Nvidia提供。也就是说,H100只是一个显卡,但是尝试可以创建服务器,包含4个或者8个H100一起互联,用以提供给大模型训练等。这里还有一个注意的Grace CPU,这是英伟达自己基于ARM开发的服务端CPU。

这里带有GH的表示配备了英伟达Grace CPU的服务器,DGX则表示是英伟达自己供应的带有GPU的服务器。

GPT-4/Falcon等模型训练用到的GPU数量这篇博客中还介绍了一些模型训练使用的GPU数量,当然这些数据原文都有参考文献和出处,我们就不列举了。

GPT-4:可能由1万到2.5万块A100训练Falcon-40B:384个A100训练Inflection用了3500个H100训练了一个等价于GPT-3.5的大模型LLaMA-1:2048个A100GPT-5:可能需要3万到5万个H100(存疑)OpenAI、特斯拉等厂商拥有的GPU数量Meta由2.1万块A100Tesla由7000块A100StabilityAI有5000块A100GPC有2.5万块H100Azure有1-4万块H100CoreWeavw有3.5-4万块H100OpenAI可能有5万块H100Infection希望有2.2万块H100Meta已经有2.5万块H100,但是希望再买1万块原文:总结一下截止2023年中旬全球主要厂商拥有的GPU数量以及训练GPT-3/LLaMA2所需要的GPU数量 | 数据学习者官方网站(Datalearner)

相关文章

猜你喜欢