【导语】

全球最新的AI技术突破——Lamini引擎发布!这一创新性引擎突破了以往训练模型的高门槛,让每个开发者都能实现训练ChatGPT的梦想。现在,AI的未来正悄然改写,普惠型的Lamini引擎正引领着全球的技术革新浪潮。而对于ChatGPT的优化,从传统的微调模式转向了简便高效的prompt-tuning,让模型的训练周期大幅缩短,性能得以稳定提升。随着Lamini的推出,AI定制化的生态愈发火爆,各种新模式如FaaS、微调即服务也应运而生。此次发布,将深刻改变AI领域的格局,让我们一起看看Lamini引擎是如何搅动AI行业的蛛丝马迹吧!

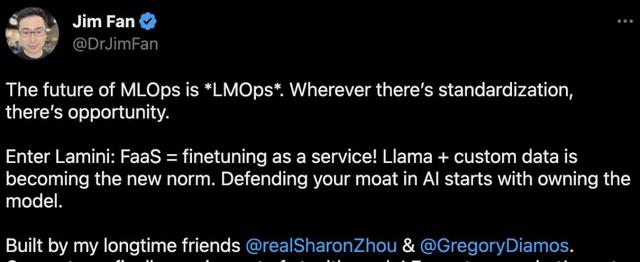

Lamini的推出也引发了AI领域的重大变革。LLM定制化的生态正在愈发火爆,新模式FaaS和微调即服务成为当下的热点话题。英伟达科学家Jim Fan表示,LLaMa 自定义数据正在成为新的范式,而Lamini引擎的问世则是这一新模式的催化剂。

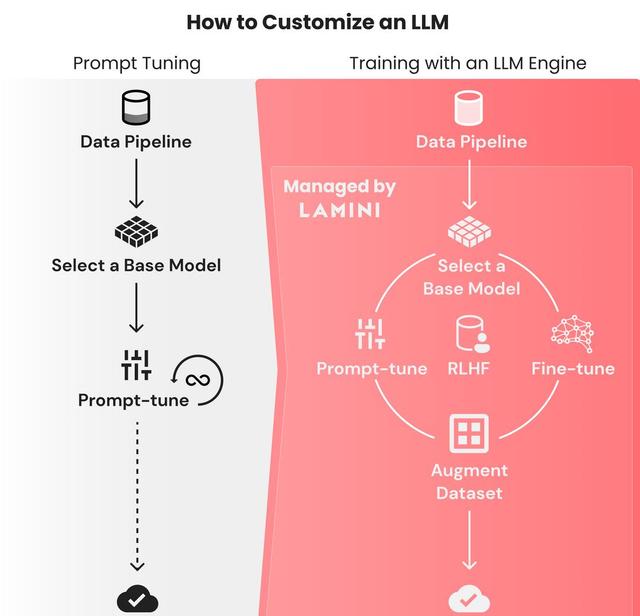

ChatGPT的优化历程也在Lamini引擎的助推下,迈向了新的里程碑。从过去繁琐的微调模式,转向了简单高效的prompt-tuning。这一过程不仅将训练周期大幅缩短,更是让性能稳步提升。微调prompt的迭代仅需几秒钟,性能调优在几个小时内即可稳定完成。这种革命性的进步,让我们看到了AI技术飞速发展的希望。

Lamini引擎的魅力在于它的简便性和高效性。通过Lamini库,只需几行代码,任何开发人员都能在大型数据集中训练出高性能的LLM,实现ChatGPT一样的优秀表现。这种快速高效的训练方式,让AI的创新与应用不再局限于少数专业团队,更多有志之士都能够参与其中,共同开创AI的新篇章。

对于想要创建自己的ChatGPT的开发者来说,Lamini引擎提供了简单易行的步骤。首先,用prompt-tuning ChatGPT或其他模型作为起点,使用Lamini库的API,轻松在不同模型之间切换。接着,构建一个大型数据集,向模型展示多样化的输入-输出对,帮助其更好地学习和理解。在大型数据集上进行微调后,再进行RLHF优化,进一步提升模型性能。

相关文章

猜你喜欢