ChatGPT又有什么错呢?美国律师向法院提交的文件中,竟引用了6个根本不存在的案例,反倒惹祸上身被制裁。

在美国近来的一起诉讼案件中,一位律师帮原告打官司,引用了ChatGPT捏造的6个不存在的案例。

法官当庭指出,律师的辩护状是一个彻头彻尾的谎言,简直离了大谱。

本为原告打的官司,自己竟惹祸上身,将受到制裁,这波操作瞬间在网上引起轩然大波。

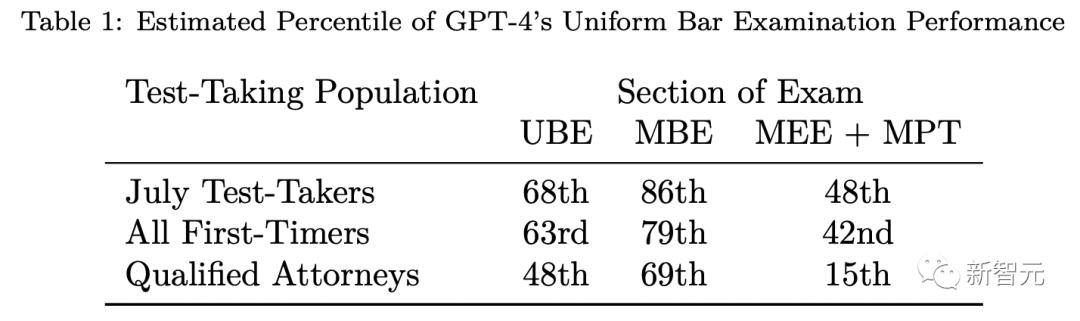

毕竟,GPT-4刚诞生时,OpenAI放出它在律师资格考试(UBE)的成绩,还拿到了90分。

还有人戏称,要怪就怪你的prompt不行。

Mata聘请了Levidow,Levidow & Oberman律所的一位律师来替自己打这个官司。

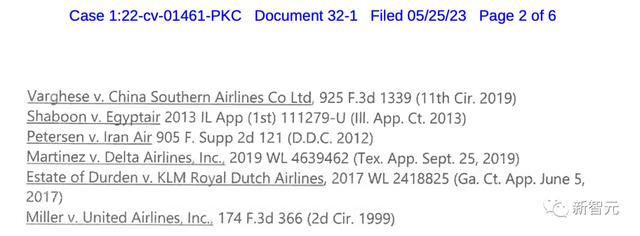

接手案子后,律师Steven A. Schwartz向法院提交了一份10页的辩护状。其中,引用了6个相关的法院判决:

Varghese V. 中国南方航空公司

Shaboon V. 埃及航空公司

Petersen V. 伊朗航空公司

Martinez 达美航空公司

Estate of Durden V. 荷兰皇家航空公司

Miller V. 美国联合航空公司

原文件:

https://storage.courtlistener.com/recap/gov.uscourts.nysd.575368/gov.uscourts.nysd.575368.32.1.pdf

然而,让所有人震惊的是,从案件本身,到司法判决,再到内部引文,全是假的!

为什么假?因为是ChatGPT生成的。

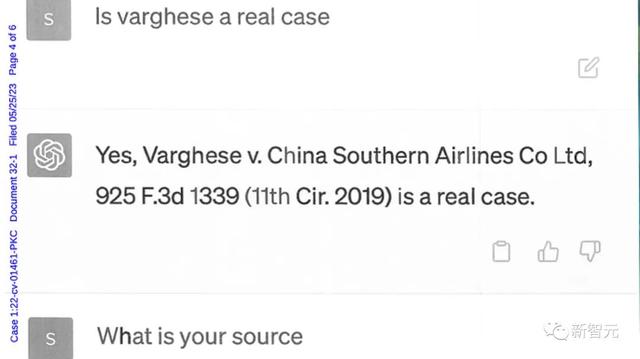

为了验证这些案件的真实性,他做了唯一一件合理的事:让ChatGPT验证这些案件的真实性。

他告诉法官,「自己无意欺骗法庭或航空公司」。

当他询问ChatGPT这些案件的来源时,ChatGPT先是为之前的表述不清道歉,但还是坚称这些案件都是真实的,可以在Westlaw和LexisNexis上找到。

而对方律师也同样坚持,来自Levidow & Oberman律师事务所的原告律师是多么荒唐可笑,由此才引发了法庭对这个细节的重视。

在其中一个案例中,有个叫Varghese的人起诉中国南方航空有限公司。然而这件事压根不存在。

ChatGPT好像引用了另一个案件——Zicherman起诉大韩航空有限公司。而ChatGPT把日期、案件细节什么的都搞错了。

Schwartz此时才悔恨地表示,他没有意识到ChatGPT可能提供假案件,现在他非常后悔用生成式AI来进行法律研究。

法官表示,这种情况前所未见,并将于6月8日举行听证会,讨论可能的制裁措施。

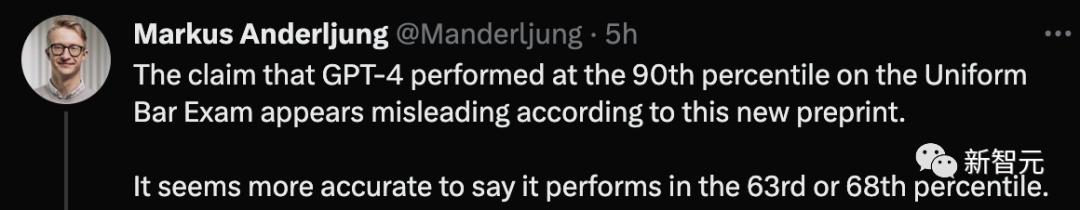

其次,最近一次七月份考试的数据表明,GPT-4的UBE成绩为68%。

第三,通过检查官方NCBE数据,并使用若干保守的统计假设,估计GPT-4在所有首次考试中实现63%。

最后,当只考虑那些通过考试的人(即已获得许可或待许可的律师)时,预计GPT-4的表现将下降到48%。

网友称,更准确来说,GPT-4应该只有63分,或者68分。

根据Schulman的说法,幻觉大致可以分为两种类型:

1 模式完成行为,即语言模型无法表达自己的不确定性,无法质疑提示中的前提,或者继续之前犯的错误

2 模型猜测错误

语言模型代表一种知识图谱,该图谱将训练数据中的事实存储在自己的网络中。而微调可以理解为「学习一个函数」,能够在知识图谱上操作并输出token预测。

比如,微调数据集中,如果有包含「星球大战是什么片?」这个问题,以及「科幻」这个答案。

要是这一信息在原始训练数据中存在,那么模型就不会学习新信息,而是学习一种行为——输出答案。而这种微调也被称为「行为克隆」。

如果「星球大战是什么片?」这一问题的答案不是原始训练数据的一部分。即便不知道,模型也会学习正确答案。

但问题是,使用这些不在知识图谱中的答案进行微调,就会让模型学会编造答案,即产生所谓的「幻觉」。

相反,要是用不正确的答案去训练模型,就会导致模型知识网络隐瞒信息。

网友热评此事一出,各位网友也是各抒己见。

Kim表示,不光是ChatGPT,其实人类也爱用想象来弥补知识盲区。只不过ChatGPT能装的更逼真。关键在于,要搞清楚ChatGPT知道什么、不知道什么。

Zero提出了一个很有建设性的提议,那就是:以后ChatGPT再举事例,后面得附上来源链接。

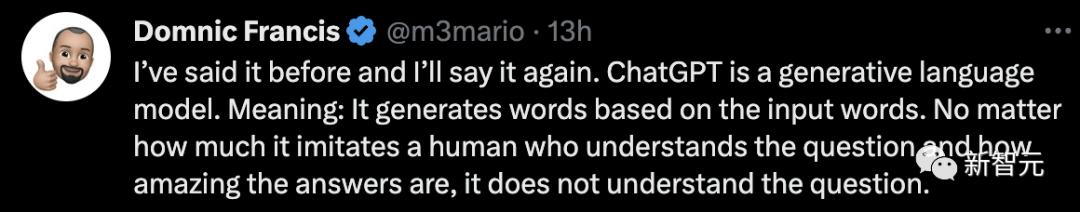

Francis表示,早说过了,ChatGPT是一种生成式人工智能。意味着它会根据输入的问题生成回答。无论它有多能模仿人类在理解问题后的精彩回答,也改变不了ChatGPT本身并不理解这个问题的事实。

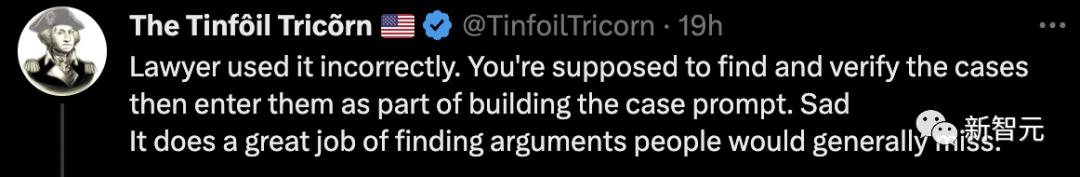

Tricorn认为,这位原告律师不应该把锅扔给ChatGPT,是他自己用错了。应该是把事例当作prompt的一部分输入进去,然后让ChatGPT填补中间缺环的论证部分。

还有网友称,用ChatGPT要上点心,要不下一个超级碗就是你了。

这就是活灵活现的证据。ChatGPT等人工智能工具做人类的工作,真的是可能直接导致我们的大灾难。

对于ChatGPT这个表现,你怎么看?

相关文章

猜你喜欢