机器之心原创

编辑:杜伟

语言大模型的终极目标是什么?

在自然语言处理(NLP)领域,暴力美学仍在延续。

自 2018 年谷歌推出 BERT(3.4 亿参数)以来,语言模型开始朝着「大」演进。国内外先后出现了参数量高达千亿甚至万亿的语言模型,比如谷歌的 T5(110 亿)、OpenAI 的 GPT-3(1,750 亿)、智源研究院的 WuDao2.0(1.75 万亿)……

有人不禁会问,语言模型的参数越来越大,它们究竟能做些什么,又智能到什么程度了呢?

9 月 28 日,浪潮人工智能研究院推出了中文巨量语言模型——源 1.0,让我们看到了语言模型超强的创作能力。

除了轻松应对大多数语言大模型都能完成的对话、故事续写、新闻生成和接对联等任务,源 1.0 还具备风格约束的诗歌创作能力,比如给出李白、杜甫或诗经风格的诗句,模型便能输出相应风格的诗句。堪称诗界的百变大师!

不仅如此,源 1.0 还具备强大的模仿能力,输入一个不存在的词语以及给出它的定义和示例。模型便能依葫芦画瓢,造出符合这个词语定义、逻辑和语境的语句。

这些只是源 1.0 一小部分创作能力的展示,一切都要归功于这个巨量中文模型具有的参数量——2,457 亿,以及它的全球最大中文数据集——5.02TB。并且,源 1.0 并不是由多个小模型堆砌形成,而是单体模型。因参数量巨大,所以称其为「巨量模型」。

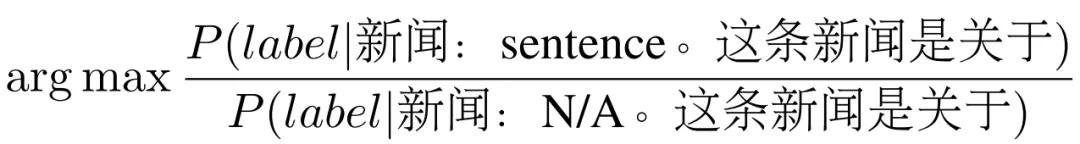

以 Tnews 任务为例,计算 sentence-lable 中 label 的概率。

原始:新闻:sentence。这条新闻是关于 label。校准:新闻:N/A。这条新闻是关于 label。代入上述计算公式后,如下所示:

通过这种空文本替换的方式,源 1.0 能够避免在固定句式表达学习上出现过拟合现象,实现小样本学习效果。

另一方面,在零样本或小样本设置下,标签在语料中出现的频率差异会对模型预测结果产生影响。理想状态下,所有标签在词表中的位置,即在语料中的出现频率,应该大致相同,但手动选择符合条件的标签非常困难。源 1.0 使用了一个涵盖 800 万个中文单词和短语的嵌入语料库,基于相似度为每个标签扩展 5 个同义词,从而扩充数据集,缓解标签分布不平衡问题,消除单个标签词带来的偏差。

概率校准和标签扩充提升了源 1.0 在零样本或小样本学习设置下的精度。以 Csldcp 和 Tnews 多分类任务以及 Eprstmt 情感分类任务为例,概率校准和标签扩充为模型带来了精度的提升。

榜单详情参见:https://www.cluebenchmarks.com/zeroclue.html

在 FewCLUE 小样本学习榜中,源 1.0 在文献摘要识别(CSLF)和名词代词关系(CLUEWSCF)两项任务上摘得榜首。

榜单详情参见:https://www.cluebenchmarks.com/fewclue.html

此外,源 1.0 在闭卷问答任务 WebQA 和文本提取任务 CMRC2018 中也表现得非常好。在这两个任务的测试中,模型直接回答 WebQA 和 CMRC2018 的问题,并且不提供任何辅助信息。

在与 PanGu-α 和 Ernie 3.0(SOTA)的比较结果可知,在 WebQA 任务上,源 1.0 在平均分数、EM 和 F1 上均实现了显著提升;对于 CMRC2018 任务,源 1.0 刷新了最优的平均分数和 F1 分数,只在 EM 分数上稍逊于 Ernie 3.0。

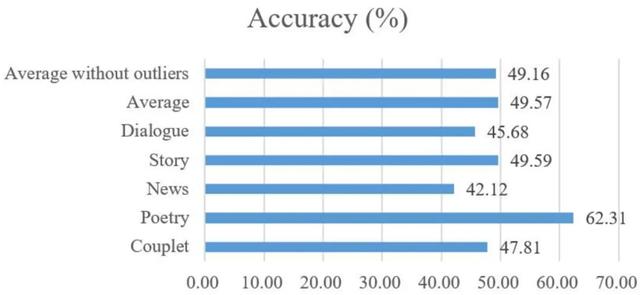

刷榜只是语言模型性能强弱的一个侧面体现,源 1.0 的创作能力在对话、故事、新闻、诗歌和对联等多样性场景中得到了进一步验证。在这些场景任务中,浪潮创建了一场「图灵测试」,用于比较源 1.0 模型生成的文本与人类创作的真实文本,并分辨出这些文本哪些「由模型生成」哪些「由人类创作」。

具体地,浪潮任意选择了源 1.0 生成的 24 篇文章,包括 4 副对联、5 首中文传统和现代诗歌、5 篇新闻文章、5 个故事和 5 段对话。其中,对联、诗歌和对话的创作被视为短文本任务,新闻和故事生成被视为长文本任务。与这些对比的人类创作的文章出自名家所作的诗歌、经典小说、搜狐新闻的新闻文章和 LCCC-large 数据集中的对话。对此,浪潮共收集了 83 份有效问卷。

结果显示,源 1.0 生成的文章只有 49.16% 的概率被正确识别为「由模型生成」,这意味着受访者难以区分人类和模型生成的文章,尤其是在对话和新闻生成这两个场景,误判率分别为 54.32% 和 57.88%。不过可以看到,由于源 1.0 的预训练语料中没有加强古汉语,源 1.0 在诗歌和对联生成场景表现相对不佳,但仍具备生成带有一定格式和格律的文本的能力。

但应看到,源 1.0 等大模型的应用场景绝对不会止步于此。12 月 11 日,机器之心举办了 NeurIPS MeetUp China,浪潮信息副总裁、人工智能 & 高性能计算 (AI&HPC) 产品线总经理刘军做了主题为《AI 大模型时代的浪潮思考与实践》演讲。他认为,未来大模型还将可能在更多应用场景中发布作用,如运营商文本类日志和报告的提取和总结、元宇宙中 AI Robot 的语言生成、理解和对话等。

语言大模型的极限在哪里?目前似乎没有哪家科技企业能够清楚地指明。浪潮的源 1.0 中文巨量语言模型,在探索 AI 拟人能力这条路上走出了坚实的一步。

最后,对刘军演讲内容感兴趣的读者,请戳以下视频:

相关文章

猜你喜欢