编辑:编辑部

【新智元导读】随着ChatGPT大火,多位AI界巨佬发出预警:有朝一日,它可能真的会消灭人类。最近,ChatGPT的大火,让人看到第四次科技革命大门开启的迹象,但也有很多人开始担心,AI是否有消灭人类的风险。

不是夸张,最近多位大佬,已经表达了这样的担忧。

ChatGPT之父Sam Altman、人工智能教父Geoffrey Hinton、比尔盖茨、纽约大学教授Gary Marcus最近纷纷提醒我们:别太大意,AI真的可能会消灭人类。

而Meta首席AI科学家LeCun画风却不太一样,他依然强调着LLM的种种缺陷,四处推荐自己的「世界模型」。

Altman:AI可能摧毁社会,不要拟人化

最近,ChatGPT之父、OpenAI CEO Sam Altman就表示,超级智能AI的风险可能会远远超出我们的预料。

在技术研究员Lex Fridman的播客中,Altman对高级人工智能的潜在危险发出了预警。

他表示自己最担心的是,AI造成的虚假信息问题,以及经济上的冲击,以及其他还没出现的种种问题,这些危害可能远远超过了人类能应对的程度。

他提出了这样一种可能性:大语言模型可以影响、甚至是主宰社交媒体用户的体验和互动。

「打个比方,我们怎么会知道,大语言模型没有在推特上指挥大家的思想流动呢?」

为此,Altman特别强调了解决人工智能对接问题的重要性,以防止AI的潜在危险。他强调,必须从技术轨迹中学习,努力解决这个问题,以确保AI的安全性。

在3月23日的一份文件中,OpenAI解释了它如何解决GPT-4的一些风险:一是通过使用政策和监测;二是通过审核内容分类器

当前真正的问题在于,我们已经拥有的人工智能技术被渴望权力的政府和企业所垄断。

幸运的是,据Hinton的观点,在事情完全失控之前,人类还有一点喘息的空间。

Hinton称,「我们现在正处于一个转折点。ChatGPT是一个白痴专家,它也不真正理解真相。因为它正试图调和其训练数据中的不同和反对意见。这与保持一致世界观的人是完全不同的。」

比尔盖茨:AI的危险,我担心很久了

而对于「AI消灭人类」这个问题,比尔盖茨已经忧心多年了。很多年来,盖茨一直表示,人工智能技术已经变得过于强大,甚至可能引发战争或被用来制造武器。

他声称,不仅现实生活中的「007反派」可能利用它来操纵世界大国,而且人工智能本身也可能失控,对人类造成极大威胁。

比起人类,它们缺少的究竟是什么呢?

要知道,如今的当红炸子鸡ChatGPT,便是一种使用深度学习生成文本的自回归语言模型。

敢对时下顶流模型进行这种否定,LeCun的话语中着实带有不少挑衅。

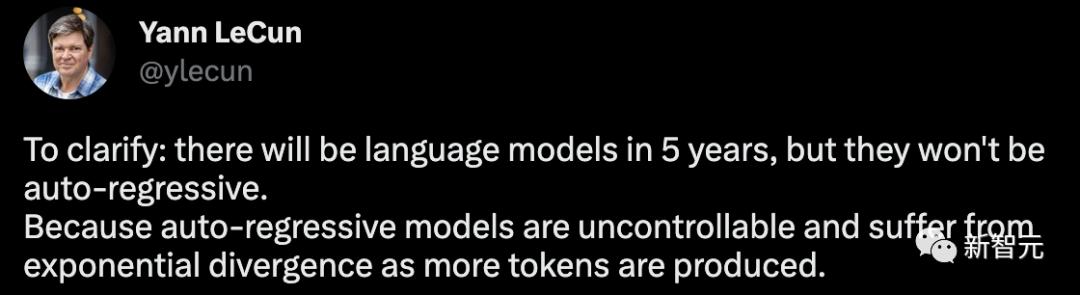

对此,他又做了一个澄清,5年后将会有语言模型,但它们不会是自回归的。因为自回归模型是不可控,并且随着产生更多的token,会出现指数级的发散问题。

我必须重申:

1. 自回归LLM是有用的,尤其是作为写作工具,编程。

2. 它们经常会产生幻觉。

3. 它们对物理世界的理解非常原始。

4. 它们的规划能力非常原始。

对于自回归LLM是指数递增的扩散过程,LeCun也给出了自己的论据:假设e是任意生成的token可能将我们带离正确答案集的概率,那么长度为n的答案最终为正确答案的概率就是P (correct) = (1-e)^n。

按照这个算法,错误会逐渐累积,正确答案的概率呈指数下降。可以通过让e更小(通过训练)来减轻问题,但是完全消除问题是不可能的。

而要解决这个问题,就得需要让LLM不再进行自回归,同时还得保持模型的流畅性。

既然如此,该怎么破?

在此,LeCun再次把自己的「世界模型」拿了出来,并指出这是LLM发展最有前途的方向。

对于构建世界模型的想法,LeCun在2022年的一篇论文A Path Towards Autonomous Machine Intelligence曾进行了具体的阐述。

若想构建一个能够进行推理和规划的认知架构,需要有6个模块组成,具体包括配置器、感知、世界模型、成本、actor,以及短期记忆。

但不可否认的是,如今ChatGPT真的让硅谷掀起了「AI掘金热」。

LLMS的炒作周期变化如此之快,每个人都处于曲线上不同的点,大家都很疯狂。

马库斯:我同意Hinton

对于Hinton的警告,纽约大学教授马库斯也表示了同意。

「是人类快要灭亡了比较重要,还是编码更快、跟机器人聊天更重要?」

马库斯认为,虽然AGI还太遥远,但LLMs已经很危险了,而最危险的是,现在AI已经在给各种犯罪行为提供便利了。

「在这个时代,我们每天都要自问,我们究竟想要什么类型的AI,有的时候走慢一点未尝不好,因为我们的每一小步都会对未来产生深远的影响。」

参考资料:

https://nypost.com/2023/03/26/artificial-intelligence-could-threaten-humanity-scientist/

https://futurism.com/the-byte/godfather-ai-risk-eliminate-humanity

相关文章

猜你喜欢