梦晨 明敏 发自 凹非寺

量子位 | 公众号 QbitAI

一觉醒来,机器学习社区炸了锅。

因为最新研究发现,只要对GPT-3说一句“让我们一步一步地思考”,就能让它正确回答出以前不会的问题。

比如下面这个例子:

16个球中有一半是高尔夫球,这些高尔夫球中有一半是蓝色的,一共有几个蓝色的高尔夫球?

(问题不难,但要注意这是零样本学习,也就是说AI训练阶段从没见过同类问题。)

如果要求GPT-3直接写出“答案是几”,它会给出错误答案:8。

但加上让我们一步一步地思考这句“咒语”后,GPT-3就会先输出思考的步骤,最后给出正确答案:4!

甚至一句最简单的“Let’s think”(让我们想一想)都能涨到57.5%。

这感觉,就像是幼儿园阿姨在哄小朋友……

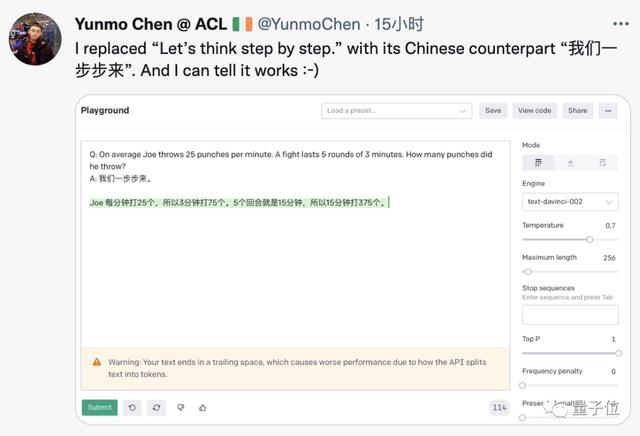

这个技巧似乎也不需要对GPT-3做魔改,已经有人在OpenAI官方Demo上成功复现,甚至换成中文也行。

英文题干中文提示,GPT-3给出正确中文答案。

对AI说“开车稳一点”会成为自动驾驶解决方案吗?

最早的CoT应用于少样本学习,在提问的同时给一个分步骤回答的示例来引导AI。

论文的最后,研究团队提出这项研究不仅可以作为零样本CoT的基线,更希望让学界认识到在构建微调数据集和少样本提示模版之前,充分发掘语言大模型零样本能力的重要性。

研究团队来自东京大学松尾研究室。

负责人松尾丰教授,同时是软银董事会中的第一位人工智能专家。

团队成员中的客座教授顾世翔来自谷歌大脑团队,顾世翔本科师从三巨头之一Hinton,博士毕业于剑桥大学。

同时,我们在吐槽队伍里又看到了马库斯的身影。

他也列出了一个失败的例子,GPT-3在“咒语”加持下也没弄明白,莎莉的牛到底会不会起死回生……

包括引爆这次话题的推特博主Aran,正是当初发现加一句“虚幻引擎”就能让AI生成图像画质飞升的那位。

前谷歌机器人大佬Eric Jang此前也发现,强化学习也能运用类似的思维来提升计算效率。

也有人表示,这种用在AI上的技巧,不正是自己平常动脑时会用的吗?

实际上,此前Bengio就从脑科学入手,提出AI的运转模式应该像人类动脑模式一样。

人类的认知任务可以分为系统1认知和系统2认知。

系统1认知任务,是指那些无意识完成的任务。比如你可以马上辨别出手里拿的是什么东西,但是却无法和别人解释,自己是怎么完成这个过程的。

系统2认知任务,是指人类大脑需要按照一定步骤完成的认知。比如做一道加减法运算,你可以很清楚地解释最终答案是如何得出的。

而这次加的“咒语”,正是让AI更进一步,学会按步骤来思考。

面对这样的趋势,有学者认为“提示工程正在取代特征工程”。

那么“提示词猎人”会成为下一代NLP研究者的外号么?

论文地址:https://arxiv.org/abs/2205.11916

参考链接:[1]https://twitter.com/arankomatsuzaki/status/1529278580189908993[2]https://evjang.com/2021/10/23/generalization.html

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态

相关文章

猜你喜欢