梦晨 萧箫 发自 凹非寺量子位 | 公众号 QbitAI

千亿级参数AI大模型,竟然真的能获取代码了?!

一觉醒来,AI圈发生了一件轰动的事情——

Meta AI开放了一个“重达”1750亿参数的大语言模型OPT-175B,不仅参数与GPT-3的1750亿一样,效果还完全不输GPT-3——

Meta AI对此解释称,OPT就是奔着开放代码去的,为了让更多人研究大模型,环境配置肯定是越经济越好。

这不,运行时产生的碳足迹连GPT-3的1/7都不到,属实省能又高效。

为了方便研究人员“量力而行”,Meta AI搞出了各种大小的OPT模型,从125M参数到1750亿参数的不同大小模型都有。

其中,660亿参数的模型还在制作中,马上也会和大伙儿见面:

当然,Meta AI也不避讳谈及OPT-175B大模型面临的一些问题,例如更容易生成“毒性语言”(例如使用有攻击性的词汇、语言歧视等):

为自Pytorch诞生之前就存在的一系列机器学习研究中的痛点和困惑提供了大厂解法的一手资料。

不过针对1750亿参数版需要申请一事,还是有人表示怀疑。

我不是学者或从业者,他们会接受我的申请吗?

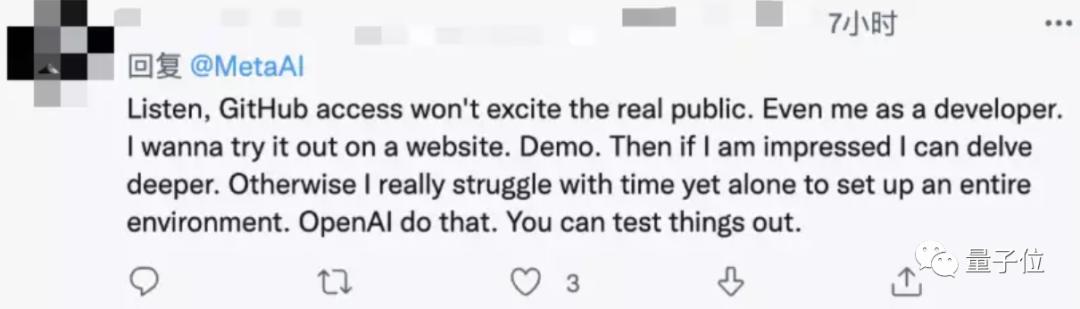

也有开发者建议Meta像OpenAI一样提供一些Demo,如果大家看到效果会更愿意参与研究改进,不然的话光是搭建开发环境就挺劝退的。

不过在OpenAI期间她并没有负责GPT-3的开发,而是参与了玩Dota的OpenAI Five强化学习项目,以及多模态大模型的研究。

项目地址:https://github.com/facebookresearch/metaseq/tree/main/projects/OPT

论文地址:https://arxiv.org/abs/2205.01068

参考链接:[1]https://ai.facebook.com/blog/democratizing-access-to-large-scale-language-models-with-opt-175b/[2]https://www.technologyreview.com/2022/05/03/1051691/meta-ai-large-language-model-gpt3-ethics-huggingface-transparency/[3]https://twitter.com/MetaAI/status/1521489996145958914

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态

相关文章

猜你喜欢