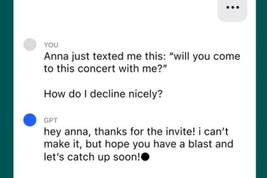

意大利禁用ChatGPT。图/IC photo

近日,意大利宣布禁止使用ChatGPT,并限制OpenAI处理意大利用户信息,同时,个人数据保护局开始对此前ChatGPT立案调查。这也使得以ChatGPT为代表的人工智能大模型还未全面进入普及应用,就迎头撞上了数据安全的质疑。

意大利此举的依据,是3月份ChatGPT出现意大利用户部分数据丢失的情况。但综合来看,应当是意大利个人数据保护局认定OpenAI在收集分析用户数据的行为中,没有遵守当地法规。例如,没有告知用户,也没有就在意大利开展业务走完收集数据的审核流程。

要看到,海量数据的积累带来了人工智能的生产力质变,同时,从互联网诞生起就始终萦绕左右的数据安全、隐私保护等问题,也成为了人工智能大模型无法回避的伴生难题。

欧洲的个人数据保护走在前列

从历史来看,ChatGPT在欧洲率先遭遇数据安全的质疑几乎是必然。

自进入互联网时代以来,欧洲在个人数据保护方面就始终走在全球前列,相关监管堪称全球最早最严。

1981年开始,欧洲议会就通过了世界上第一个个人数据保护条例,此后,相关的监管条例始终紧跟技术变化,甚至始终领先技术一步。例如,1995年,欧盟进一步针对个人数据隐私和流动通过了新的立法,而此时,互联网时代也只是刚刚开启而已。

今时今日,关于个人数据保护的概念,多是在欧洲被率先定义,例如,数据的知情同意权、被遗忘权、数据携带权等等。因此,意大利援引全世界最严格的数据保护条例,对现在仍在测试阶段的ChatGPT进行封禁,既显得突然,同时又顺理成章。

客观上说,当前的ChatGPT在数据隐私、合规、伦理等领域的确处在测试探索阶段,用户在使用的同时,也在不断提供新的数据来训练该模型。

正因为仍处在黑盒测试之中,这些数据的合法性来源、用户数据尤其是隐私的保护、黑盒中的数据与知识产权冲突等问题,都给法律、监管带来了新的挑战。因此,审慎为上的欧洲才决定采取一刀切的封杀政策。

举个例子,与互联网时代的搜索引擎不同,ChatGPT本质上是直接模拟人类的思维与语言模式提供答案,其最终目标是为了“取悦用户”,而不是为了提供真实信息。那么,当用户在使用中被告知了一套虚假信息,导致了现实中的利益受损,这种虚假信息导致的安全问题应该如何界定?

安全与创新之间的平衡挑战

如何确保数据授权、界定数据安全的责任与科技公司的义务,规避隐私泄露、知识产权等风险,这些都将是人工智能在大规模介入公共领域后,必须首先解决的问题。

但与此同时,意大利这种一刀切的政策也并不值得鼓励。

过于严格且一刀切的监管政策,曾扼杀了欧洲在互联网时代的科技创新能力。今天,在关于欧洲为何错过移动互联网时代的讨论中,过于严苛缺少弹性的监管政策,一直被视为重要原因。

例如,2016年欧盟通过了史上最严格的个人数据保护法之后,多家全球科技企业在欧洲均卷入了在数据上的反复博弈。

2019年,美国信息技术和创新基金会下属的数据创新中心曾发布报告指出,欧盟的数据保护条例并未产生预期的积极效果,反而增加了企业的数据合规成本、损害科技公司创新和竞争力,同时增加了消费者获取在线服务的成本和不信任感。

回到人工智能领域,在全球大赛跑的背景下,既要提前设定红线和规则以保护公民数据安全,同时,又要防止监管过度带来的创新不足问题,这是各国共同面对的政策难题,需要不断寻找两者之间的平衡。

唯一可以确定的是,从人类近百年来科技创新与伦理冲突的经验来看,在科技即将带来生产力革命的前夜,提前思索、讨论和商定包容审慎监管的细节,远比亡羊补牢更好。

撰稿 / 马尔文(互联网从业者)

编辑 / 刘昀昀

校对 / 刘越

相关文章

猜你喜欢